Intro

我是 M4n5ter ,将在这里记录我的学习过程 :)

参照 rust course 而建

我的 GO 从这开始

the way to go

GitHub - unknwon/the-way-to-go_ZH_CN: 《The Way to Go》中文译本,中文正式名《Go 入门指南》

ZincObserve

ZincObserve (以下简称 ZO)是由 zinclabs 开源的一款日志搜索引擎(他们之前有一款产品叫做 zincsearch,现在已经基本由社区驱动,原因是他们最初的目的是开发一款在日志搜索领域做的最好的软件,现在已经全部精力投入到 ZincObserve了),目的是在 logs,metrics,traces 搜索领域替代 elasticsearch ,我们都知道 elasticsearch 非常笨重,资源消耗极大,而 ZO 专精与日志搜索,所以全文搜索、向量搜索等请移步 meilisearch、zincsearch、elasticsearch、qdrant 等其它软件。

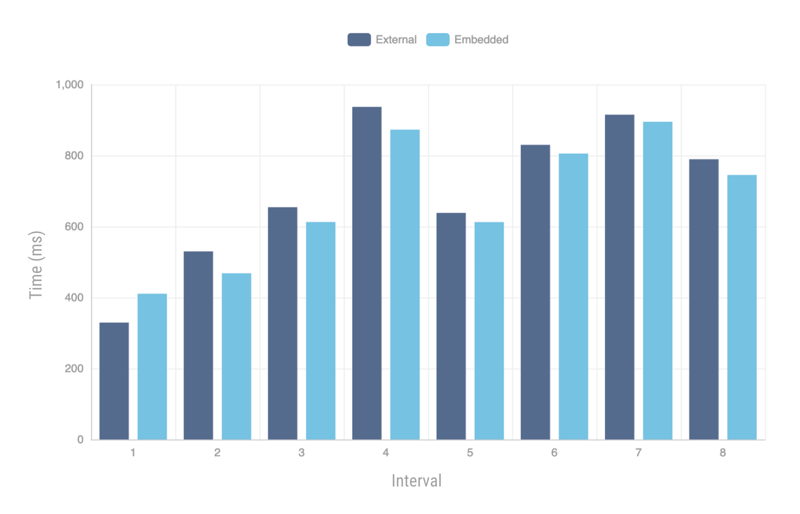

ZO 使用 Rust 开发(他们家的 zincsearch 是用的 go),性能极高,存储成本仅仅为 elasticsearch 的 1/140。目前 ZO 的后端部分已经基本稳定,现在提出的 bugs 基本都是前端问题。虽然 ZO 从版本号来看还没有为生产做好准备,但是鉴于 zincsearch 的优良表现,我们完全可以相信 zinclabs 的能力(毕竟他们创立的目的就是为了开发一款世界上最好的日志搜索软件)。

将 Gin 的日志输出到 ZincObserve

zincobserve

ZO 支持 win/linux/mac/docker/k8s ,这里我直接从 Releases · zinclabs/zincobserve · GitHub 下载

wget https://github.com/zinclabs/zincobserve/releases/download/v0.4.1/zincobserve-v0.4.1-linux-amd64.tar.gz

tar zxvf zincobserve-v0.4.1-linux-amd64.tar.gz

ZO 是通过环境变量的方式来配置的,会从 .env 读取,这里就指定一下最小配置量的环境变量。

$ cat .env

ZO_ROOT_USER_EMAIL=admin@m4n5ter.email

ZO_ROOT_USER_PASSWORD=123456

$ ./zincobserve

fluent-bit

首先,我们需要有东西来采集日志,这里我使用 fluent-bit ,fluent-bit 支持大量的 input 和 output 插件,其中 output 插件有 elasticsearch 支持,这里提到这个插件是因为 ZO 兼容 ES API,可以直接使用 ES output plugin,但是我这里不使用这个插件,而是直接使用 http output plugin。

而 input 插件我这里就使用 tcp input , 其实 tail 插件也可以,tail 支持从文件系统中读取日志,只需要将 gin 的日志输出一份到磁盘就行。但是使用 tcp input 的话,我们可以将fluent-bit 放在其它地方,只要网络可达就能采集日志,更加灵活。

首先下载一个 fluent-bit,这里使用 docker 的方式,方便一些:

docker pull cr.fluentbit.io/fluent/fluent-bit:2.1.1

具体 tags 可以去 fluent-bit 官网那看看需要哪个版本即可。

准备一份配置文件:

config:

[INPUT]

Name tcp

Listen 0.0.0.0

Port 5170

Chunk_Size 32

Buffer_Size 64

Format json

[OUTPUT]

Name http

Match *

URI /api/default/test/_json

Host localhost

Port 5080

tls Off

Format json

Json_date_key _timestamp

Json_date_format iso8601

HTTP_User admin@m4n5ter.email

HTTP_Passwd uoZ9nMUEywjSLAiP

这里的 [OUTPUT] 直接访问 http://<IP>:<Port> 在 ZO 的 WEB 界面选择采集(ingestion)后选择 fluent-bit 就能得到。URL /api/{组织}/{数据流}/_json ,这里的组织和数据流随便都行, 没有的话 ZO 会自动创建。

$ docker run -it --network host -v .:/data --rm --name fluent-bit cr.fluentbit.io/fluent/fluent-bit:2.1.1 \

-c /data/config

直接前台运行 fluent-bit 方便直接看到日志。

[error] [config] indentation level is too low

这里启动报了个错,翻译过来意思就是缩进太短了,编辑 config 发现是从 ZO WEB界面复制出来的 OUTPUT 跟原来的 INPUT 缩进不一样,给 OUTPUT 再多缩进一些跟 INPUT 对齐就行了。

Gin

一个简单的可以实现我们的目的的 Demo

main.go

package main

import (

"fmt"

"github.com/gin-gonic/gin"

"io"

"net"

"time"

)

// 确保 FluentBit 实现了 io.Writer 接口

var _ io.Writer = (*FluentBit)(nil)

var (

// DefaultInterval 默认与 fluent-bit 的连接断开后,重连的间隔时间

DefaultInterval = time.Second

// Address fluent-bit 的地址

Address = "127.0.0.1:5170"

)

// FluentBit 表示与 fluent-bit 的连接

type FluentBit struct {

address string

conn net.Conn

intervalTicker <-chan time.Time

}

var fb FluentBit

// 初始化时连接 fluent-bit,并且设置 gin 的日志输出到 fluent-bit

func init() {

// 不需要控制台输出,这里禁用控制台输出的颜色

gin.DisableConsoleColor()

fb = FluentBit{

address: Address,

intervalTicker: time.Tick(DefaultInterval),

}

fb.Connect()

gin.DefaultWriter = &fb

}

func main() {

// 检测与 fluent-bit 的连接是否断开,如果断开则重连

go func() {

for {

<-fb.intervalTicker

if _, err := fb.Write([]byte("")); err != nil {

fb.Reconnect()

}

}

}()

r := gin.New()

// 使用自定义的日志格式,这里用 json 格式,方便 fluent-bit 解析

// ZO 会根据接收到日志的时间自动添加 _timestamp 字段

// 这里我们自己指定一个 _timestamp,这样 ZO 会直接使用我们添加的

r.Use(gin.LoggerWithFormatter(func(param gin.LogFormatterParams) string {

return fmt.Sprintf(`{"_timestamp":"%d","log":"%s - %s %s %s %d %s %s %s"}`,

param.TimeStamp.UnixNano(),

param.ClientIP,

param.Method,

param.Path,

param.Request.Proto,

param.StatusCode,

param.Latency,

param.Request.UserAgent(),

param.ErrorMessage,

)

}))

r.Use(gin.Recovery())

// 简单的 ping pong 用来测试

r.GET("/ping", func(c *gin.Context) {

c.String(200, "pong")

})

_ = r.Run(":8080")

}

func (f *FluentBit) Write(b []byte) (n int, err error) {

return f.conn.Write(b)

}

func (f *FluentBit) Close() {

_ = f.conn.Close()

}

func (f *FluentBit) Connect() {

conn, _ := net.Dial("tcp", f.address)

f.conn = conn

}

func (f *FluentBit) Reconnect() {

f.Close()

f.Connect()

_, _ = f.Write([]byte(`{"message":"reconnect to fluent-bit"}`))

}

这里为 FluentBit 实现的方法,它们的方法对象都是 *FluentBit,原因是在 GO 中都是值传递,如果方法对象是 FluentBit ,那么在调用方法的时候 FluentBit 结构体会被克隆一份然后在克隆出来的FluentBit上执行方法。

而考虑到可能 tcp 会断连(比如 fluent-bit 挂掉了),我们需要重连 tcp,如果方法对象是 FluentBit 则会导致重连后 gin 拿到的 Writer 仍旧是断连前的那个(因为重连这个操作是在克隆出来的结构体上执行的,新的连接是放入的克隆出来的结构体内)。

这里小记一下:在 go 中,当一个方法接收者是具有一定的共享属性时,要使用指针接收者,或者方法接收者不是由普通的 go 内建类型构成的,比较庞大,这时克隆一份接收者的成本过高,也应该使用指针接收者

测试是否成功

go run .

控制台没有日志输出,因为日志直接写入 fluent-bit 了。

再看 fluent-bit

[ warn] [input:tcp:tcp.0] invalid JSON message, skipping

新增了这样的日志输出,这是因为 gin 启动的时候会打印一些东西,那些不是 json。无关紧要。

接下来测试一下:

$ curl -i localhost:8080/ping

HTTP/1.1 200 OK

Content-Type: text/plain; charset=utf-8

Date: Tue, 25 Apr 2023 12:02:37 GMT

Content-Length: 4

pong

这时 fluent-bit 中新打印了一条:

[ info] [output:http:http.0] localhost:5080, HTTP status=200

{"code":200,"status":[{"name":"default","successful":1,"failed":0}]}

说明成功了。

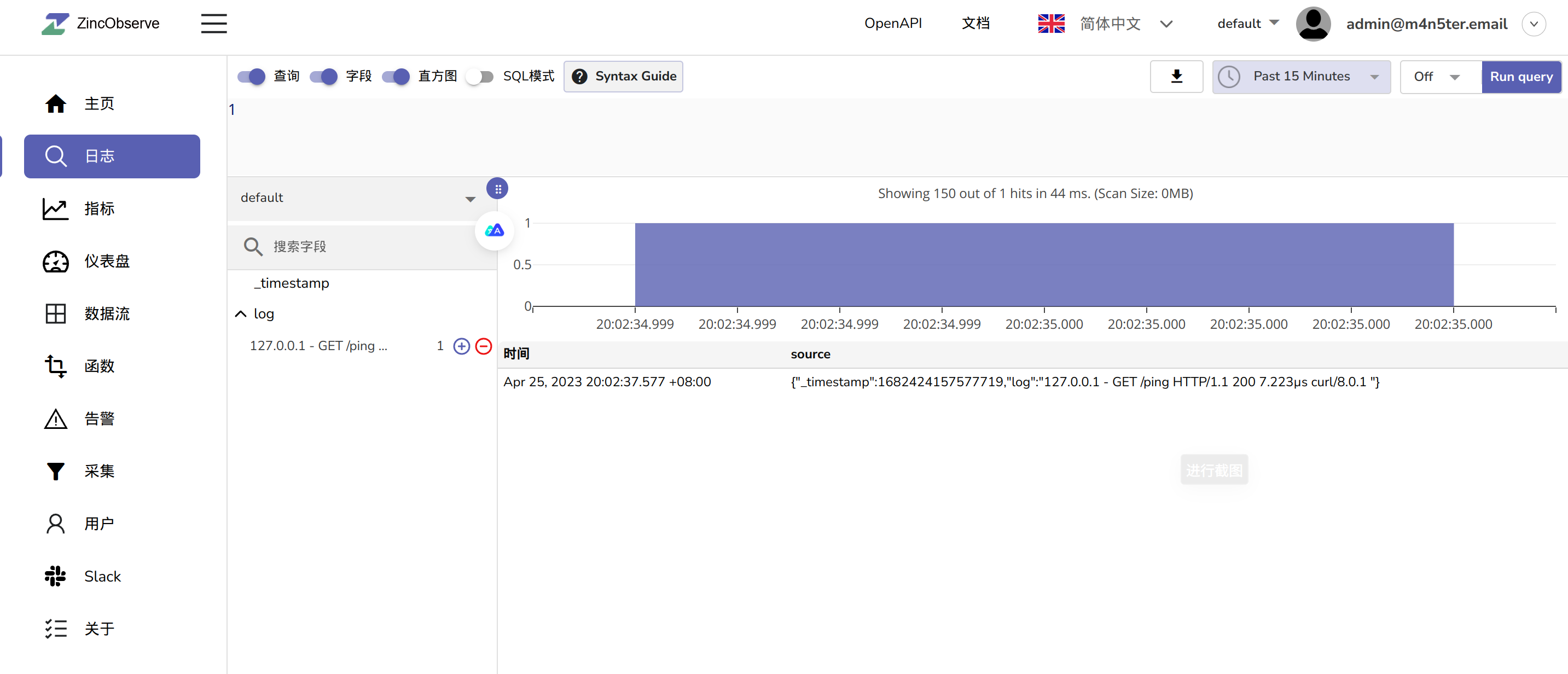

去 ZO WEB 页面看看:

可以看到成功了,到这里我们的目的就达成了。

如何替换 Logstash

上面我们是直接将日志发送到 fluent-bit,再由 fluent-bit 直接发送给 ZO,但是如果有大量不同应用程序的日志需要搜集,那么日志会非常混乱不好管理,这时就需要在发送给 ZO 之前清洗日志了,而 Logstash 就能干这个(fluent-bit 本身也有一定这方面能力),但是 Logstash 也是蛮重量级的,我们不想要消耗这么多资源怎么办?

go-zero 的作者 kevwan 有开源一个项目,叫做 go-stash ,能够从 kafka 摄取数据并加工后发送到 elasticsearch ,并且吞吐量能达到 logstash 的 5倍。

但是但是吧,Kafka 也是蛮重量级的,如果业务环境中本身没有 kafka ,为了这个特地多加一个 kafka,系统复杂度上去了不说,还有额外运维成本,还有服务器资源成本。那有没有轻量级的替代呢?也有,CNCF的云原生消息系统 NATS 可以替换 kafka,并且 NATS 也能直接和 fluent-bit 联动。

写一个自己的 "go-stash"

我们还是需要一个类似于 go-stash 的东西,来加工 fluent-bit 收集的日志,需要能够直接支持从 fluent-bit 接收数据,和从 NATS 接收数据并加工处理后发送到 ZO。

需求:

-

input 至少支持 fluent-bit/NATS

-

output 至少支持 ZO/ES(ZO 兼容 ES API)

-

需要够轻量,使用 GO 或 RUST 开发

接下来我会抽时间持续更新这块,若大体完成我会在 github 上开源这个工具。

ptash

为了解决上一块内容最后的需求,我打算爆改 go-stash,使其满足我们的需求。下面是项目地址,我会持续更新。

我的 rust 从这开始

rust 官方 the book 的译本

rust cn 社区圣经

我的 rustlings 5.2.1 版本解决方案

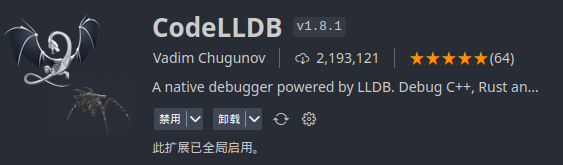

我的 rust 相关 vscode 拓展以及配置

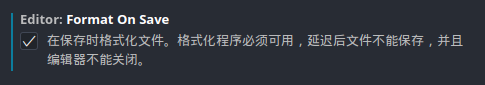

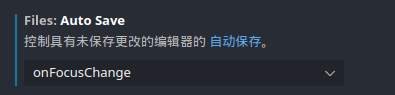

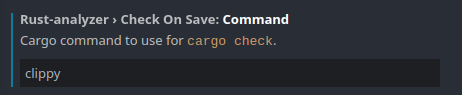

以及一些设置:

简介

Tower 是一个专注于对网络编程进行抽象的框架,将网络编程中的各行为进行抽象从而提高代码复用率。

Tower 最核心的抽象为 Service trait,其接受一个 request 进行处理,成功则返回 response,否则返回 error。

#![allow(unused)] fn main() { async fn(Request) -> Result<Response, Error> }

这个抽象可以同时运用于客户端和服务端。同时 Tower 也提供了 超时处理、访问频率限制和负载均衡之类的组件,这些功能可以被抽象为在 inner Service 调用之前和之后进行一些操作所共同组成的Service。这些 Service 称为中间件(middleware)。

Tower 库对 Service 的设计希望满足以下目标:

- 能够满足异步编程的规范

- 不同的 Service 能够灵活地层层嵌套

- 我们在给一个 Service 递交 request 时,希望能够得到该 Service 的执行情况;如果该 Service 负载过重,则需要延缓提交 request 甚至直接丢弃 request,这一点类似于 Future 中的 poll 方法。

针对第一点,当 call 一个 Service 时,会直接返回一个 Future,由调用者决定怎么安排这个 Future,而不是要求实现了 Service trait 的结构体同时也实现 Future。

针对第二点,每个实现了 Service 的结构体自身可以继续携带一个 Service,只需要将 request 递交给里层的 Service,就实现了 Service 的嵌套,这样本结构体就成为了一个中间件。

针对第三点,在 Service 中定义了 poll_ready 方法用于获取一个 Service 的执行情况。

#![allow(unused)] fn main() { trait Service<Request> { type Response; type Error; type Future: Future<Output = Result<Self::Response, Self::Error>>; fn poll_ready(&mut self, cx: &mut Context<'_>) -> Poll<Result(), Self::Error>>; fn call(&mut self, req: Request) -> Self::Future; } }

通过 Service trait 实现 Timeout 中间件

Timout 中间件用于对某个 request 的处理限定时间,如果超过时限还没有返回,则直接返回错误。Timout 应该有个用于进一步处理的里层serivce和一个时限。

#![allow(unused)] fn main() { struct Timeout<T> { service: T, duration: std::time::Duration } }

将 Timeout 也定义为一个 Service

#![allow(unused)] fn main() { impl<S, Request> Service<Request> for Timeout<S> where S: Service<R>, S::Error: Into<Box<dyn std::error::Error + Send + Sync>> }

poll_ready 非常好处理,直接将调用里层 Service 的 poll_ready 函数。

而 call 则要求返回一个 Future,如果要实现 Timeout 对应的行为逻辑,需要创建一个新的实现了 Future 的类型——ResponseFuture。我们希望它被poll时,首先会查看里层 Service 是否返回,如果已返回则返回结果,如果没有则检查是否已经timeout,如果没有则返回 Pending,如果已经超时则返回超时错误。

因此我们创建了一个融合了里层 future 和超时 future 的类型

#![allow(unused)] fn main() { #[pin_project] struct ResponseFuture<F> { #[pin] response_future: F, #[pin] sleep: tokio::time::Sleep } }

pin_project 可以使得 Pin 类型的字段也是 Pin 类型,在调用 poll 函数时需要用到。

然后为 ResponseFuture 实现 Future trait

#![allow(unused)] fn main() { impl<F, Response, Error> Future for ResponseFuture<F> where F: Future<Output = Result<Response, Error>>, Error: Into<Box<dyn std::error::Error + Send + Sync>> { type Output = Result<Response, Box<dyn std::error::Error + Sync + Send>>; fn poll(self: std::pin::Pin<&mut Self>, cx: &mut Context<'_>) -> Poll<Self::Output> { let this = self.project(); match this.response_future.poll(cx) { Poll::Ready(res) => { let result = res.map_err(Into::into); return Poll::Ready(result); }, Poll::Pending => {} } match this.sleep.poll(cx) { Poll::Ready(_) => { let error = Box::new(TimeoutError(())); Poll::Ready(Err(error)) }, Poll::Pending => Poll::Pending } } } }

Balance 中间件

从名字就可以看出来,Balance 模块用于提供负载均衡的服务,负载均衡会根据所有服务的负载程度来决定处理 request 的服务。

在官方文档提供了两种 Balance 服务

- p2c:根据p2c算法 (Power of Two Random Choices) 实现,提供一种简单而大概的 service 选择方法,一般在无法精确每个 service 的负载时使用。

- pool:实现了一个动态大小的服务池 (service pool),通过追踪每个 service 的

poll_ready成功的次数来估计每个 service 的负载状况。(虽然这个模块还存在于官方文档之上,但是已经从最近的源码上移除了,显然官方打算移除这个模块,参见#658。

这里选择p2c算法进行分析。p2c 并非是一种挑选最优的算法,而是一种避免选到最坏的算法。其随机从所有 service 中选取两个,比较两个 service 的负载,选择较小的那个 service,从而保证避免选到负载最重的 service。这个算法在 nginx 中就有所运用。

Balance 内部通过 ready_cache 模块维护一个 Pending 队列和一个 Ready map,当 Service 陷入 Pending 状态时,则加入 Pending 队列中,新加入的 Service 一开始也是加入到 Pending 队列中。可以通过调用 promote_pending_to_ready 函数遍历所有的 Pending Service 将已经 Ready 的 Service 加入到 Ready map 中。

同样,Balance 也实现了 Service trait:

poll_ready:只有有存在一个被选中的 Service 是ready的,那么就可以返回 ready,并记录该 Service 的 indexcall:直接调用上面的 index 对应的 Service 处理 request,这也就是为什么 Tower 建议在调用某个 Service 之前一定要调用poll_ready询问服务是否空闲。对应的 Service 在被调用之后会被插入到 Pending 队列中。

综上所述,Balance 模块提供了一种 Service 集托管服务,通过将 Service 集托管到 Balance 模块,由 Balance 决定 request 交给哪个 Service 处理。

Buffer 中间件

Buffer 中间件希望提供一个类似于 mpsc 一样多生产者单消费者一样的缓存队列,可以允许多个用户同时像某个 Service 提交 request,更重要的是,Service 要能够将 request 的执行结果返回给用户。

Buffer 中间件的做法是将 Service 看作一个生产者,另外定义一个 Worker 作为消费者,Worker 负责接收 request 并处理。

#![allow(unused)] fn main() { struct Worker<T, Request> where T: Service<Request> { current_message: Option<Message<Request, T::Future>>, rx: mpsc::Receiver<Message<Request, T::Future>>, service: T, finish: bool, failed: Option<ServiceError>, handle: Handle } }

Worker 维护了一个 mpsc channel 的接收端rx,而每个 Buffer Service 维护了一个 mpsc channel 的发送端tx,且 Buffer 实现了 Clone trait,当 Buffer 被 clone 时,对应的 tx 也被clone。

由于用户的 request 是由 Buffer 转交给 Worker 的,因此 request 的处理结果无法直接从 Buffer 获取。这里就体现了 Service trait 的灵活性,由于 Service 的call函数返回的是一个 Future,因此可以自定义一个 ResponseFuture,然后在 Worker 要处理的 Message 中包含一个 channel 的发送端,在call函数返回的 Future 中包含该 channel 的接收端,就可以使得 Worker 和用户之间可以直接通信。这个设计应该说是非常巧妙的。

#![allow(unused)] fn main() { impl<Req, Rsp, F, E> Service<Req> for Buffer<Req, F> where F: Future<Output = Result<Rsp, E>> + Send + 'static, E: Into<Box<dyn std::error::Error + Send + Sync>>, Req: Send + 'static { type Response = Rsp; type Error = Box<dyn std::error::Error + Send + Sync>; type Future = ResponseFuture<F>; fn call(&mut self, request: Rsp) -> Self::Future { let span = tracing::Span::current();//这个不用管 let (tx, rx) = oneshot::channel();//构建一次性管道用于传输返回结果。 match self.tx.send_item(Message {request, span, tx}) { Ok(_) => ResponseFuture::new(rx), Err(_) => {} } } } }

Discover 中间件

在前面的 Balance 中间件中提到了 Service 集的概念,有集合,就意味着有集合内元素的变动。各个中间件对于 Service 集合的实现可能并不相同,但是都对外提供了统一的增删接口,这个接口就是 Discover trait。

Discover 为了方便对 Service 集进行管理,要求用户对每个 Service 定义一个唯一的标识符并且实现了 Eq。

对 Service 集的修改主要就是增加和删除,用枚举 Change 表示:

#![allow(unused)] fn main() { enum Change<K, V> { Insert(K, V), Remove(K) } }

对于一个维护 Service 集的struct,其对 Service 集的修改选择交给用户,由用户提供一个实现 Discover trait 的 struct,而维护 Service 集的 struct 只需要调用 poll_discover 函数就可以获取外界对 Service 集的修改。

#![allow(unused)] fn main() { trait Discover: Sealed<Change<(), ()>> { type Key: Eq, type Service; type Error; fn poll_discover( self: Pin<&mut self>, cx: &mut Context<'_> ) -> Poll<Option<Result<Change<Self::Key, Self::Service>, Self::Error>>>; } }

Tips: 在Rust异步编程中,很多的poll及类似的函数的返回结果都是 Poll<Option<Result<V, E>>> 类型的。这种返回类型可以从结果上反映很多东西,通常用于需要被多次poll的函数。

- Poll::Pending: 暂时没有value返回,和普通的poll函数类似

- Poll::Ready(None): 当前Future结束,不会再yield任何值

- Poll::Ready(Some(Ok(_))): 当前 Future yield 一个值,可能还需要被poll

- Poll::Ready(Some(Err(_))): 当前 Future 产生错误,需要进行处理

这一套规则在很多 Rust 异步编程代码中都有体现,可以看作 Rust 异步编程中的潜规则。

值得注意的是,这里的 Sealed 是一个空 trait,并且在crate之外无法访问,但是在 discover 模块中为所有实现了 TryStream 的类型实现了 Sealed

#![allow(unused)] fn main() { impl<K, S, E, D: ?Sized> Sealed<Change<(), ()>> for D where D: TryStream<Ok = Change<K, S>, Error = E>, K: Eq, {} }

也就是说,要实现 Discover 首先要实现 TryStream,而在 discover 中也为所有实现了 TryStream 的类型自动实现了 Discover trait:

#![allow(unused)] fn main() { impl<K, S, E, D: ?Sized> Discover for D where D: TryStream<Ok = Change<K, S>, Error = E>, K: Eq, { type Key = K; type Service = S; type Error = E; fn poll_discover( self: Pin<&mut Self>, cx: &mut Context<'_>, ) -> Poll<Option<Result<D::Ok, D::Error>>> { TryStream::try_poll_next(self, cx) } } }

也就是将 Discover 抽象为流式操作,这样就可以用到很多现成的实现了 Stream 的工具来存储对于 Service 集的修改。

Filter 中间件

Filter 顾名思义,对于 request 进行一次筛选,只有符合筛选条件的 request 才会提交给 Service 处理。

#![allow(unused)] fn main() { struct Filter<T, U> { inner: T, predicate: U } }

可以看出,Filter 的初始定义非常自由,Filter 对 predicate 并没有任何限制,但是 Filter 必须要根据 predicate 的返回结果分别处理,所以 Filter 和 predicate 总是相关的。

Filter 只对于当 predicate 实现了 Predicate trait 时实现了 Service trait。

#![allow(unused)] fn main() { trait Predicate<Req> { type Request; fn check(&mut self, request: Request) -> Result<Self::Request, Box<dyn std::error::Error + Send + Sync>>; } }

实现过程也很有意思,由于call函数要求返回一个 Future,因此当筛选不通过时,需要返回一个立刻返回 Ready(Err(_)) 的 Future

#![allow(unused)] fn main() { impl<T, U, Request> Service<Request> for Filter<T, U> where U: Predicate<Request>, T: Service<U::Request>, T::Error: Into<BoxError>, { type Response = T::Response; type Error = BoxError; type Future = ResponseFuture<T::Response, T::Future>;//即future_util::future::Either; fn poll_ready(&mut self, cx: &mut Context<'_>) -> Poll<Result<(), Self::Error>> { self.inner.poll_ready(cx).map_err(Into::into) } fn call(&mut self, request: Request) -> Self::Future { ResponseFuture::new(match self.predicate.check(request) { Ok(request) => Either::Right(self.inner.call(request).err_into()), Err(e) => Either::Left(futures_util::future::ready(Err(e))), }) } } }

async predicate

上面讲的predicate函数并不是异步的,这只适用于一些快速筛选的 Filter,如果 predicate 过程也需要等待IO等适合做成异步的场景,那么应该将 predicate 过程也做成异步形式。因此 Filter 模块还存在一个适用于异步场景的 AsyncFilter。

这就导致在一个 Service 同时存在两种 Future,用户也不知道两种 Future 的先后关系,因此需要将两种 Future 放到一个 AsyncResponseFuture,由 AsyncResponseFuture 协调两个 Future。

#![allow(unused)] fn main() { enum State<F, G> { Check {check: F}, WaitResponse {response: G} } struct AsyncResponseFuture<P, S, Request> where P: AsyncPredicate<Request>, S: Service<P::Request> { state: State<P::Future, S::Future>, service: S } }

AsyncResponseFuture 的 poll 结果由当前 state 决定。

#![allow(unused)] fn main() { impl<P, S, Request> Future for AsyncResponseFuture<P, S, Request> where P: AsyncPredicate<Request>, S: Service<P::Request>, S::Error: Into<crate::BoxError>, { type Output = Result<S::Response, crate::BoxError>; fn poll(self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll<Self::Output> { let mut this = self.project(); loop { match this.state.as_mut().project() { StateProj::Check { mut check } => { let request = ready!(check.as_mut().poll(cx))?; let response = this.service.call(request); this.state.set(State::WaitResponse { response }); } StateProj::WaitResponse { response } => { return response.poll(cx).map_err(Into::into); } } } } } }

Limit 中间件

服务器的处理能力是有限的,如果短时间内到达的 request 过多,可能会导致系统宕机。Limit 中间件用于对 request 进行限制,主要分为两种方式:

- concurrency: 限制并发处理的 request 数量

- rate:限制 request 处理的速率

concurrency 很好实现,只需要在 Service 维护一个信号量 semaphore,每要处理一个 request 就获取一个信号量,使得并发处理的数量不会超过信号量的值。

rate 可以表示为每一段时间允许的 request 数量:

#![allow(unused)] fn main() { struct Rate { num: u64, per: Duration } }

借助 tokio::time::sleep_util future,限制 now 到 now+per 这段时间内的 request 处理数量。

#![allow(unused)] fn main() { impl<S, Request> Service<Request> for RateLimit<S> where S: Service<Request> { type Response = S::Response; type Error = S::Error; type Future = S::Future; fn call(&mut self, request: Request) -> Self::Future { match self.state { State::Ready{mut until, mut rem} => { let now = Instant::now(); if now >= until { until = now + self.rate.per(); rem = self.rate.num(); } if rem > 1 { rem -= 1; self.state = State::Ready{until, rem}; } else { self.sleep.as_mut().reset(until); self.state = State::Limited; } self.inner.call(request); } State::Limited => panic!("service not ready") } } } }

Load 中间件

Load 是用于定量化表示一个 Service 的负载的中间件。调用 Balance layer 的 Service 集就要求 Service 必须实现 Load trait。

#![allow(unused)] fn main() { trait Load { type Metric: PartialOrd, fn load(&self) -> Self::Metric; } }

Load 提供下列三个计算 Service 负载的模块:

- Constant:将 Service 的 Load 指标设为常数;

- PendingRequests: 根据 Service 的 Pending request 的数量作为 Service 的负载指标;

- PeakEwma: 峰值移动指数平均算法,将 request 的 rtt 时间作为 Service 的负载指标,rtt 即 request 从被接收到返回 response 中间经历的时间。

同时 Load 维护一个平均 rtt 时间,如果最新 request 的 rtt 大于平均 rtt,则取最新 rtt 作为平均 rtt(这就是峰值移动指数平均法的意思);如果 rtt 小于平均rtt,则根据最新 rtt 和移动指数平均算法计算平均rtt。

第二、第三个模块显然需要追踪每个 request 的运行情况,为了解决这个问题,两个模块在实现 Service trait 的 call 函数时会返回一个 TrackCompletionFuture

#![allow(unused)] fn main() { struct TrackCompletionFuture<F, C, H> { #[pin] future: F, handle: Option<H>, completion: C } }

其中,handle 为通知 Service request 已经完成的柄,TrackCompletionFuture 只需要负责在 request 执行完成之后 drop handle,由具体的模块去实现 handle 被 drop 时需要实现的动作。

比如 PeakEwma 模块的 handle 需要追踪从接收 request 到执行完成的时间:

#![allow(unused)] fn main() { struct Handle { sent_at: Instant, decay_ns: f64, rtt_estimate: Arc<Mutex<RttEstimate>> } impl Drop for Handle { fn drop(&mut self) { let recv_at = Instant::now(); if let Ok(mut rtt) = self.rtt_estimate.lock() { rtt.update(self.sent_at, recv_at, self.decay_ns);//涉及到PeakEwma算法的实现。 } } } }

至于 PendingRequests 就更简单了,其 handle 直接就是一个 Arc<()> 类型的 wrap,直接调用 Arc 类型的 strong_count 函数就知道当前 Pending 的 request 数量。

LoadShed 中间件

LoadShed 类似于 Rust 中的一些 try_xxx 函数,其 poll_ready 函数返回 Poll<Result<(), E>> 类型,当 poll_ready 被调用时,总是返回 Ready,但是根据里层的类型判断里层 Service 是否真的 Ready,这个中间件适用于一些特殊的场景。

如果在 Service not ready 的情况下调用call函数,则会返回 overloaded 错误。

Make 中间件

Make 中间件是一种产生 Service 的 Service,适用于一些需要产生新的 Service 来进行处理的场景。Tower 给出的例子是 TCP listener,当收到一个新的 TCP 连接时,listener 需要创建一个新的 Service 来处理 TCP stream。

#![allow(unused)] fn main() { trait MakeService<Target, Request>: Sealed<(Target, Request)> { type Response; type Error; type Service: Service<Reuquest, Response = Self::Response, Error = Self::Error>; type MakeError; type Future: Future<Output = Result<Self::Service, Self::MakeError>>; fn poll_ready(&mut self, cx: &mut Context<'_>) -> Poll<Result<(), Self::MakeError>>; fn make_service(&mut self, target: Target) -> Self::Future; } }

MakeService 已经为所有 Response type 为 Service 类型的 Service 自动实现。

#![allow(unused)] fn main() { impl<M, S, Target, Request> MakeService<Target, Request> for M where M: Service<Target, Response = S>, S: Service<Request>, { type Response = S::Response; type Error = S::Error; type Service = S; type MakeError = M::Error; type Future = M::Future; fn poll_ready(&mut self, cx: &mut Context<'_>) -> Poll<Result<(), Self::MakeError>> { Service::poll_ready(self, cx) } fn make_service(&mut self, target: Target) -> Self::Future { Service::call(self, target) } } }

service_fn 组件

Tower 提供了一个可以快速将一个签名为

#![allow(unused)] fn main() { async fn(req: Request) -> Result<Response, Box<dyn std::error::Error + Send + Sync>>; }

的异步函数包装为一个 Service 的函数 service_fn,其就是一个 Make Service。这种包装很简单,因为每个异步函数在调用时编译器会自动生成一个 Future。

#![allow(unused)] fn main() { struct ServiceFn<T> { f: T } impl<T, F, Request, R, E> Service<Request> for ServiceFn<T> where T: FnMut(Request) -> F, F: Future<Output = Result<R, E>>, { type Response = R; type Error = E; type Future = F; fn poll_ready(&mut self, _: &mut Context<'_>) -> Poll<Result<(), E>> { Ok(()).into() } fn call(&mut self, req: Request) -> Self::Future { (self.f)(req) } } }

Reconnect 中间件

Reconnect 是一个可以在发生错误时自动重连的中间件,一个 Reconnect Service 有三种状态:

- Idle: 暂时没有任何服务连接,当在这个状态 poll_ready 时,需要根据内部的一个 MakeService 中间件创建一个 Service Future 并跳到 Connecting(MakeService::Future) 状态

- Connecting: 通过前一步的 Service Future 进行 poll,如果返回 Ready 则跳到 Connected(Service) 状态,如果有错误则跳到 Idle 状态

- Connected: 调用内层 Service 的 poll_ready,如果返回错误,则需要重新创建连接,跳到 Idle 状态

在 poll_ready 函数中,遇到 Poll::Ready(Ok()) 或 Poll::Pending 则直接返回,如果遇到 Poll::Ready(Err()) 则不断循环,直到 Service 正常,因此为 Reconnect。从这一点来看,poll_ready 其实永远不会返回 Poll::Ready(Err(_)),但是为了后续的扩展性,在函数签名上还是有。

Reconnect 如果在非 Connected 状态下调用 call 函数则会 panic。

Retry 中间件

Retry 中间件试图将多次里层 Service 的 poll 表现为一次,最简单的场景,对于一个比较繁忙的 Service,单次 poll 可能会返回 Error,于是我可能希望将 Service Future 的一次 poll 表现为里层 Service 每隔一段时间进行一次 poll 进行多次,直到成功返回 Ready 或达到次数限制。Retry 中间件就适用于这些场景。

显然上面只是一种最简单的场景,Tower 为了给予用户最大的 Retry 定制化空间,只需要用户决定是否继续 retry 的类型实现 Policy trait

#![allow(unused)] fn main() { trait Policy<Req, Res, E>: Sized { type Future: Future<Output = Self>; fn retry(&self, req: &Req, result: Result<&Res, &E>) -> Option<Self::Future>; fn clone_request(&self, req: &Req) -> Option<Req>; } }

其中 retry 函数用于决定是否应该继续 retry,如果返回 None 则停止,否则返回 Some(Future)。Future 可以在被 poll 时每次生成一个新的实现了 Policy 的 Retry Service,这意味着每次 retry 之后都可以产生新的 Service,而不是只能一直使用同一种 Policy,进一步增大了自由度。

最后再看 Tower 给的 Retry Service 对于 call 函数的 ResponseFuture 的实现。ResponseFuture 包含三种状态:

- Called(service_future): 可以poll一次里层 Service,如果是 Pending 则直接返回 Pending。否则调用 retry 函数生成一个新的 Retry Service Future,跳到 Checking(retry_future) 状态

- Checking(retry_future): 等待 retry_future 生成新的 Retry Service 的中间态,如果生成 Retry Service 则跳到 Retrying 状态

- Retrying: 等待里层 Service poll_ready 的中间态,如果里层 Service 已经 Ready,则调用里层 Service 的call函数生成 service_future 并跳到 Called(service_future) 状态

SpawnReady 中间件

SpawnReady 在官方文档上的介绍是 "Drive a service to readiness on a background task"。如果我们需要尽快察觉到某个 Service 已经 ready,那我们可能会经常去 poll_ready 一下,而 SpawnReady 就是将这件事包装为一个 Service,并且在内部包装一个 task 用于检查内层 Service 是否 ready。假设 executor 里面只有两个 task,那么一个是真正在做事的 task,另一个则是检查前一个 task 是否 ready 的 task。

#![allow(unused)] fn main() { impl<S, Req> Service<Req> for SpawnReady<S> where Req: 'static, S: Service<Req> + Send + 'static, S::Error: Into<BoxError>, { type Response = S::Response; type Error = BoxError; type Future = ResponseFuture<S::Future, S::Error>; fn poll_ready(&mut self, cx: &mut Context<'_>) -> Poll<Result<(), BoxError>> { loop { self.inner = match self.inner { Inner::Service(ref mut svc) => { if let Poll::Ready(r) = svc.as_mut().expect("illegal state").poll_ready(cx) { return Poll::Ready(r.map_err(Into::into)); } let svc = svc.take().expect("illegal state"); let rx = tokio::spawn(svc.ready_oneshot().map_err(Into::into).in_current_span()); Inner::Future(rx) } Inner::Future(ref mut fut) => { let svc = ready!(Pin::new(fut).poll(cx))??; Inner::Service(Some(svc)) } } } } } }

通过 ready_oneshot 函数将 Service 包装为一个 ReadyOneshot task,然后通过 tokio::spawn 传入 executor

Steer 中间件

Steer 中间件用于管理 Service 数组,根据自定义的规则将 request 导向特定的 Service。

#![allow(unused)] fn main() { trait Picker<S, Req> { fn pick(&mut self, r: &Req, services: &[S]) -> usize; } }

由于 Steer 内部维护多个 Service,所以只有多个 Service 同时 ready, Steer 才会返回 Ready。

#![allow(unused)] fn main() { struct Steer<S, F, Req> { router: F, services: Vec<S>, not_ready: VecDeque<usize>, _phantom: PhantomData<Req> } impl<S, Req, F> Service<Req> for Steer<S, F, Req> where S: Service<Req>, F: Picker<S, Req>, { type Response = S::Response; type Error = S::Error; type Future = S::Future; fn poll_ready(&mut self, cx: &mut Context<'_>) -> Poll<Result<(), Self::Error>> { loop { // must wait for *all* services to be ready. // this will cause head-of-line blocking unless the underlying services are always ready. if self.not_ready.is_empty() { return Poll::Ready(Ok(())); } else { if self.services[self.not_ready[0]] .poll_ready(cx)? .is_pending() { return Poll::Pending; } self.not_ready.pop_front(); } } } fn call(&mut self, req: Req) -> Self::Future { assert!( self.not_ready.is_empty(), "Steer must wait for all services to be ready. Did you forget to call poll_ready()?" ); let idx = self.router.pick(&req, &self.services[..]); let cl = &mut self.services[idx]; self.not_ready.push_back(idx); cl.call(req) } } }

这样的处理实际会拖累整体的效率,如果某个 request 所需要的 Service 实际是 ready 的,但是可能为了等待其他的 Service 而延缓调用。但是为了兼容 Tower 的核心 API 不得不这么处理,毕竟 poll_ready 会与 request 相关的 Service 只有这一个。

结论

Tower 将网络编程中常见的行为抽象为统一的 Service,对外的接口非常统一,并且可以相互叠加,而且是异步式,是一个扩展性非常强大的框架,值得学习一下。

摘自https://zhuanlan.zhihu.com/p/548090197

介绍

mini-redis 是一个不完整的使用 tokio 构建的 redis client 和 server 。

是 tokio 团队提供的一个用于学习 tokio 的稍大的示例项目,接下来将以 mini-redis 作为我的第一个用来学习 Rust 的项目。

该项目的目的即是进行 tokio 教学(Tokio Tutorial),所以接下来就跟着 Tokio Tutorial 走吧~

开始

Tokio Tutorial 将会带着我们逐步完成 mini-redis 的客户端和服务端。从使用 Rust 进行异步编程的基础知识开始,并从那里开始构建。我们将实现Redis命令的一个子集,但将全面了解Tokio。

获得帮助

tokio 的 Discord 和 GitHub discussions 是初学者获得帮助的好地方,在那里不用担心提一些“初学者才会提的问题”,大家都是从某个地方开始,很乐意帮忙。

先决条件

在该教程中说明了教程需要读者已经熟悉了 Rust 编程语言,并且推荐了 Rust book,当然 rust cn 社区有一本同样优秀的 Rust course 。

虽然不是必需的,但有使用Rust标准库或其他语言编写网络代码的一些经验可能会有所帮助。

Rust

本教程至少需要Rust版本1.45.0,但建议使用Rust的最新稳定版本。

rustc --version

rustc 1.64.0 (a55dd71d5 2022-09-19)

Mini-Redis server

接下来需要安装 Mini-Redis server 来保证我们写的客户端能被测试。

cargo install mini-redis

如果因为国内糟糕的网络环境导致下载速度不忍直视,可以使用字节跳动 Rust 技术团队的 rsproxy 来替换默认源。

通过启动 server 来确保我们已经成功安装。

mini-redis-server

接着另外打开一个终端窗口,尝试使用mini-redis-cli get 一个 key 。

mini-redis-cli get foo

不出意外你会看到 (nil) 。

准备开始

就是这样,一切准备就绪。转到下一页编写我们的第一个异步Rust应用程序。

Hello Tokio

我们将从编写一个非常基本的 Tokio 应用程序开始。它将连接到 Mini-Redis 服务器,设置 key hello 的值为 world 。然后它将读回 key。这将使用 Mini-Redis 的客户端库完成。

代码

生成一个新的 crate

cargo new my-redis

cd my-redis

添加依赖

接下来打开 Cargo.toml 并把下面的内容添加到 [dependencies] 下:

tokio = { version = "1", features = ["full"] }

mini-redis = "0.4"

写代码

然后打开 main.rs 并将文件的内容替换成下面的:

use mini_redis::{client, Result}; #[tokio::main] async fn main() -> Result<()> { // 向 mini-redis 的地址打开一个连接. let mut client = client::connect("127.0.0.1:6379").await?; // 设置一个叫 `hello` 的 key,它的内容是 `world` client.set("hello", "world".into()).await?; // 去 get 这个 `hello` let result = client.get("hello").await?; println!("从服务端得到了值; result={:?}", result); Ok(()) }

确保 Mini-Redis server 正在运行,找个单独的终端窗口执行:

mini-redis-server

现在,让我们运行我门的 my-redis 应用程序。

❯ cargo run

Finished dev [unoptimized + debuginfo] target(s) in 0.15s

Running `target/debug/my-redis`

从服务端得到了值; result=Some(b"world")

这样便是成功了,也算是即将要开始 coding 了!

看看具体发生什么

让我们回顾一下刚刚做的事情,代码量不多,但是其实发生了很多事情。

#![allow(unused)] fn main() { let mut client = client::connect("127.0.0.1:6379").await?; }

client::connect 函数是由 mini_redis 这个 crate 提供的。它通过异步的方式向指定的地址建立一个 TCP 连接。一旦连接成功建立了,将会返回一个 Client handle(中文叫句柄)(这里给它起了个名 "client")。

即使这个操作是异步执行的,但是我们写的这个代码看起来像是同步的。通过 .await 操作符来表明这是一个异步操作。

何为异步编程?

相信看过 The book 或者 Rust course 的大伙都知道,下面就贴原文啦~

Most computer programs are executed in the same order in which they are written. The first line executes, then the next, and so on. With synchronous programming, when a program encounters an operation that cannot be completed immediately, it will block until the operation completes. For example, establishing a TCP connection requires an exchange with a peer over the network, which can take a sizeable amount of time. During this time, the thread is blocked.

With asynchronous programming, operations that cannot complete immediately are suspended to the background. The thread is not blocked, and can continue running other things. Once the operation completes, the task is unsuspended and continues processing from where it left off. Our example from before only has one task, so nothing happens while it is suspended, but asynchronous programs typically have many such tasks.

Although asynchronous programming can result in faster applications, it often results in much more complicated programs. The programmer is required to track all the state necessary to resume work once the asynchronous operation completes. Historically, this is a tedious and error-prone task.

当然还有机翻可供粗略观摩:

大多数计算机程序都是按照它们编写的顺序执行的。第一行执行,然后是下一行,依此类推。使用同步编程,当程序遇到不能立即完成的操作时,它会阻塞,直到操作完成。例如,建立传输控制协议需要通过网络与对等方进行交换,这可能需要相当长的时间。在此期间,线程被阻塞。 对于异步编程,不能立即完成的操作会被挂起到后台。线程不会被阻塞,并且可以继续运行其他事情。一旦操作完成,任务就会被取消挂起,并从它停止的地方继续处理。我们之前的示例只有一个任务,所以挂起时什么都不会发生,但是异步程序通常有许多这样的任务。 虽然异步编程可以带来更快的应用程序,但它通常会导致更复杂的程序。一旦异步操作完成,程序员需要跟踪恢复工作所需的所有状态。从历史上看,这是一项乏味且容易出错的任务。

编译期的绿色线程(Compile-time green-threading)

green-threading我的理解是一种非常轻量的“线程”,比如协程(coroutine),以及直接被融入Go runtime的goroutine(类似 coroutine,但又不同) 。

Rust 通过叫作 async/await 的特征来实现异步编程。执行异步操作的函数用 async 关键字来标记。在我们的示例中,connect函数是这样定义的:

#![allow(unused)] fn main() { use mini_redis::Result; use mini_redis::client::Client; use tokio::net::ToSocketAddrs; pub async fn connect<T: ToSocketAddrs>(addr: T) -> Result<Client> { // ... } }

async fn 这样的定义方式看起来像是一个常规的同步函数,但是以异步的方式运行。

Rust 在编译期将 async fn 转化为一个异步运行的 routine (不是 coroutine,不要理解错误)。

在 async fn 中对 .await 的任何调用都会将控制权返回给线程(即让出当前线程),此时这个操作会被放在后台,而线程可能会去做一些别的事情。

尽管也有其它语言实现了

async/await,但 Rust 采用了一种独特的方法。大多情况下,Rust 的异步操作表现为

lazy,这导致了不同于其它语言的运行时语义。

如果还是不太明白,没有关系!我们将会在这整个教程中探索到更多关于 async/await 的知识。

使用 async/await

异步函数的调用与任何其他Rust函数一样。但是,调用这些函数不会导致函数体执行。换而言之,调用异步函数会返回一个代表这个操作的值(在概念上类似于一个没有参数的闭包)。

如果要真正地去执行这个操作,需要对这个返回值使用 .await 操作符。

就像下面这样:

async fn say_world() { println!("world"); } #[tokio::main] async fn main() { // 直接调用 `say_world()` 并不会执行它的函数体。 let op = say_world(); // 这个 println! 会先出现。 println!("hello"); // 对 `op` 调用 `.await`。 op.await; }

输出会是下面这样的:

hello

world

async fn 的返回值是实现 Future trait的匿名类型。

Future 可以被看作是一个会在未来的某个时间点被执行的东西。

异步的 main 函数

main 函数与大多数的 Rust crate 不同,它被用来启动一个应用程序。

-

它是一个

async fn -

它是用

#[tokio::main]来注释的

当我们想进入一个异步的上下文,会使用 async fn。然而,异步函数必须被一个 runtime 所执行(tokio 就是 Rust 社区大名鼎鼎的异步运行时)。runtime 包括异步任务调度器、提供事件 I/O、计时器等。runtime 不会自动启动,所以 main 函数需要去启动它。

#[tokio::main] 是一个宏。它将 async fn main() 转化为一个同步fn main(),初始化了一个 runtime 实例并且执行了这个异步 main 函数。

例如以下内容:

#[tokio::main] async fn main() { println!("hello"); }

被转化成:

fn main() { let mut rt = tokio::runtime::Runtime::new().unwrap(); rt.block_on(async { println!("hello"); }) }

tokio runtime 的细节将在后面介绍。

Cargo features

在本教程引入 tokio 依赖时,full feature flag 被启用了。

tokio = { version = "1", features = ["full"] }

Tokio 有很多功能(TCP、UDP、Unix sockets、timer、sync utilities、multiple scheduler types 等)。并非所有应用程序都需要所有功能(full)。当尝试优化编译时间或最终应用程序占用空间时,应用程序可以决定只选择它用到的那些功能。

目前,我们在依赖 tokio 时使用 full feature,来方便 code。

Spawning

我们接下来准备开始完成我们的 Redis server!

首先,把上一部分的客户端的 SET / GET 代码移动到一个示例文件中去,这样我们可以在 server 上去运行它。

mkdir -p examples

mv src/main.rs examples/hello-redis.rs

创建一个新的空的 src/main.rs 后再继续。

Accepting sockets(从 sockets 接收)

英语水平有限,这小标题只能翻译成这样了 :(

首先我们的 Redis server 第一件需要做的事情就是接受入站的 TCP sockets。用 tokio::net::TcpListener 来完成。

Tokio 的许多类型用了与 Rust 标准库中的等价的同步类型一样的名字。并且 Tokio 使用

async fn暴露了与std相同的APIs

一个 TcpListener 绑定在 6379 端口,接着 socket 们会在一个 loop 中被接受。每个 socket 都会被处理然后关闭。现在,为门将要读取命令,然后打印它到标准输出,并且回复一个 error。

use mini_redis::{Connection, Frame}; use tokio::net::{TcpListener, TcpStream}; #[tokio::main] async fn main() { // 绑定 listener 到一个地址 let listener = TcpListener::bind("127.0.0.1:6379").await.unwrap(); loop { // 解构出来的第二个 item 包含一个新 connection 的一对 IP 和 port,这里将其忽略了 let (socket, _) = listener.accept().await.unwrap(); process(socket).await; } } async fn process(socket: TcpStream) { // `Connection` 让我们能够读写 redis **frames**(抽象的帧) 而不是 // byte streams(字节流). `Connection` 类型由 mini-redis 定义。 let mut connection = Connection::new(socket); if let Some(frame) = connection.read_frame().await.unwrap() { println!("GOT: {:?}", frame); // Respond with an error let response = Frame::Error("unimplemented".to_string()); connection.write_frame(&response).await.unwrap(); } }

现在把它跑起来:

cargo run

在另一个终端窗口,运行 hello-redis example(上一节我们写的那个 SET / GET)

cargo run --example hello-redis

输出应该得是像下面这样:

Error: "unimplemented"

在跑服务端的那个终端,输出应该是下面这样:

GOT: Array([Bulk(b"set"), Bulk(b"hello"), Bulk(b"world")])

Concurrency (并发)

我们的 server 有一个问题(除去只回复了错误)。它一次只会处理一个入站请求:当一个连接被接受,我们的 server 停留在 accept loop 里面,直到 response 被完全写入 socket。

我们肯定是希望我们的 Redis server 能够处理并发的请求,为了达到这个目的,我们需要加并发。

并发(concurrency)和并行(parallelism)不是一回事。如果一个线程交替执行两个任务,那么就是同时(CPU 有能力让你感觉到是“同时”,尽管同一时间点一个线程只可能在处理一个任务)处理这两个任务(这是并发),但不是并行处理。要让这变成并行,那么至少需要 2 个线程,每个线程都执行一个任务。

使用

Tokio的优点之一是异步代码允许您同时处理许多任务,而不必使用普通线程并行处理它们。事实上,Tokio可以在单个线程上同时运行许多任务!

为了并发处理这些连接,对每个入站连接都得生成一个新任务,连接会在这个新任务中被处理。

accept loop 会变成这样:

use tokio::net::TcpListener; #[tokio::main] async fn main() { // 绑定 listener 到一个地址 let listener = TcpListener::bind("127.0.0.1:6379").await.unwrap(); loop { // 解构出来的第二个 item 包含一个新 connection 的一对 IP 和 port,这里将其忽略了 let (socket, _) = listener.accept().await.unwrap(); // 生成一个新任务,socket 的所有权被移动到了这个新任务里面,并在那里被处理。 tokio::spawn(async move { process(socket).await; }); } }

Tasks

一个 Tokio 任务是一个异步的 green thread。他们是通过 async 块传递给 tokio::spawn 来创建的。tokio::spawn 函数返回一个 JoinHandle,使得 JoinHandle 的调用者可以与生成的任务进行交互。async 块可以拥有返回值,调用者通过在 JoinHandle 上使用 .await 来获取返回值。

举个栗子:

#[tokio::main] async fn main() { let handle = tokio::spawn(async { // 在这里做了一些异步的事情 "return value" }); // 又做了一些别的事情 let out = handle.await.unwrap(); println!("GOT {}", out); }

.await 会让出当前线程的控制权,并等待 JoinHandle 返回一个 Result。当一个任务在执行期间遇到了一个错误,JoinHandle 将会返回一个 Err ,当任务 panic 又或者是因为 runtime 关闭而被强制取消也会发生前面那个事件。

Task 是由 scheduler 管理的执行单位。Spawn (生产) 一个任务会把任务提交给 Tokio scheduler来确保任务在有工作要做时执行。生产出来的任务可能会在它们被生产的线程上执行,也有可能会在不一样的 runtime thread 上被执行。任务被生产后也能够在不同线程间移动。

任务在 Tokio 中是非常非常轻量的。在底层,它们只需要一次分配和64字节的内存。应用程序应该可以随意生成数千甚至数百万个任务。

'static bound(静态生命周期绑定)

当我们在 Tokio runtime 上生成了一个任务,其类型的生命周期必须是 'static。这意味着生成的任务不得包含对任务外部拥有的数据的任何引用。

一个常见的错觉是:

'static总是意味着 "永远存活",但事实并非如此。仅仅因为一个值是静态的并不意味着你有内存泄漏。想知道更多可以看这里 Common Rust Lifetime Misconceptions 。

举个不能被编译通过的例子:D

use tokio::task; #[tokio::main] async fn main() { let v = vec![1, 2, 3]; task::spawn(async { println!("Here's a vec: {:?}", v); }); }

尝试编译它会有如下报错:

#![allow(unused)] fn main() { error[E0373]: async block may outlive the current function, but it borrows `v`, which is owned by the current function --> src/main.rs:7:23 | 7 | task::spawn(async { | _______________________^ 8 | | println!("Here's a vec: {:?}", v); | | - `v` is borrowed here 9 | | }); | |_____^ may outlive borrowed value `v` | note: function requires argument type to outlive `'static` --> src/main.rs:7:17 | 7 | task::spawn(async { | _________________^ 8 | | println!("Here's a vector: {:?}", v); 9 | | }); | |_____^ help: to force the async block to take ownership of `v` (and any other referenced variables), use the `move` keyword | 7 | task::spawn(async move { 8 | println!("Here's a vec: {:?}", v); 9 | }); | }

这种情况会发生是因为默认情况下,变量不会被 move 到 async block。这个 v Vector 被 main 函数保留了所有权。println! 只是借用了 v。rust 编译器向我们解释了这一点,甚至提出了修复建议!(rust 编译器还是一如既往的牛逼!尽管它的严格经常会让我很挫败:( )

按 rust 编译器说的来,在第 7 行处为 async block 加上 move ,现在这个 task 就拥有了 v 的所有权而不是借用,并且让它变成了 'static。

如果必须同时从多个任务访问单个数据,那么就必须使用 Arc 等同步原语共享它。

下面引用的内容我觉得比较难理解:

Note that the error message talks about the argument type outliving the

'staticlifetime. This terminology can be rather confusing because the'staticlifetime lasts until the end of the program, so if it outlives it, don't you have a memory leak? The explanation is that it is the type, not the value that must outlive the'staticlifetime, and the value may be destroyed before its type is no longer valid.When we say that a value is

'static, all that means is that it would not be incorrect to keep that value around forever. This is important because the compiler is unable to reason about how long a newly spawned task stays around. We have to make sure that the task is allowed to live forever, so that Tokio can make the task run as long as it needs to.The article that the info-box earlier links to uses the terminology "bounded by

'static" rather than "its type outlives'static" or "the value is'static" to refer toT: 'static. These all mean the same thing, but are different from "annotated with'static" as in&'static T.

留意关于参数类型的寿命超过了 ’static 生命周期的错误信息。这个术语可能会让人很困惑,因为 'static 生命周期将会一直存在直到程序结束,所以如果比它寿命还长,确定没有内存泄漏吗? 关于这个的解释是:它是一个类型,而不是一个必须寿命长过 'static' 的值,并且它的值可能会在它的类型失效之前被销毁。

当我们说一个值是 'static 的时候,这意味着永远留着它常常是正确的。这非常重要,因为编译器无法推断新生成的任务会保留多长时间。我们不得不确保任务被允许一直存活(仅仅是允许,但不是必须),这样 Tokio 就可以让任务运行它实际需要的时间。

前面的信息框链接到的文章使用术语 “以 'static 为界” 而不是 “其类型的寿命超过 'static ” 或 “其值是 'static" 来指代 T:'static。这些都意味着同一件事,但不同于 &‘static T 中的 “用 'static 注释”

插一句嘴:上面这块儿我是琢磨了很久,但是还有一些内容没完全明白,看来还是有待提升呐~

Send bound

从 tokio::spawn 生成的任务必须实现 Send trait 。这样才能当任务被 .await 后允许 Tokio runtime 在线程之间移动他们。

因为水平有限,可能有误,所以附上原文后再给出我的理解:

Tasks are

Sendwhen all data that is held across.awaitcalls isSend. This is a bit subtle. When.awaitis called, the task yields back to the scheduler. The next time the task is executed, it resumes from the point it last yielded. To make this work, all state that is used after.awaitmust be saved by the task. If this state isSend, i.e. can be moved across threads, then the task itself can be moved across threads. Conversely, if the state is notSend, then neither is the task.

当一个任务内所有跨过 .await 调用的数据都实现了 Send 时,这个任务才是实现了 Send 的。如下例子就会因为 a 没有实现 Send 且跨过了 .await 调用而导致编译失败:

use tokio::net::TcpListener; #[tokio::main] async fn main() { // 绑定 listener 到一个地址 let listener = TcpListener::bind("127.0.0.1:6379").await.unwrap(); loop { // 解构出来的第二个 item 包含一个新 connection 的一对 IP 和 port,这里将其忽略了 let (socket, _) = listener.accept().await.unwrap(); let a = Rc::new("Rc does not impl Send"); // 生成一个新任务,socket 的所有权被移动到了这个新任务里面,并在那里被处理。 tokio::spawn(async move { process(socket).await; println!("{:?}", a); }); } }

#![allow(unused)] fn main() { error: future cannot be sent between threads safely --> src/main.rs:16:9 | 16 | tokio::spawn(async move { | ^^^^^^^^^^^^ future created by async block is not `Send` | = help: within `impl std::future::Future<Output = ()>`, the trait `std::marker::Send` is not implemented for `std::rc::Rc<&str>` note: captured value is not `Send` --> src/main.rs:18:30 | 18 | println!("{:?}", a); | ^ has type `std::rc::Rc<&str>` which is not `Send` note: required by a bound in `tokio::spawn` --> /home/m4n5ter/.cargo/registry/src/rsproxy.cn-8f6827c7555bfaf8/tokio-1.21.2/src/task/spawn.rs:127:21 | 127 | T: Future + Send + 'static, | ^^^^ required by this bound in `tokio::spawn` error: could not compile `my-redis` due to previous error }

因为用了 .await 后,当前任务会让出线程控制权,任务的当前状态会被整个打包,并且可能会在多个线程间传递这个任务,存在任务会在不同的线程被执行的可能,而数据在线程间传递要求实现 Send trait 。

下面是官方给出的两个例子:

成功:

use tokio::task::yield_now; use std::rc::Rc; #[tokio::main] async fn main() { tokio::spawn(async { // The scope forces `rc` to drop before `.await`. { let rc = Rc::new("hello"); println!("{}", rc); } // `rc` is no longer used. It is **not** persisted when // the task yields to the scheduler yield_now().await; }); }

失败:

use tokio::task::yield_now; use std::rc::Rc; #[tokio::main] async fn main() { tokio::spawn(async { let rc = Rc::new("hello"); // `rc` is used after `.await`. It must be persisted to // the task's state. yield_now().await; println!("{}", rc); }); }

错误报告:

#![allow(unused)] fn main() { error: future cannot be sent between threads safely --> src/main.rs:6:5 | 6 | tokio::spawn(async { | ^^^^^^^^^^^^ future created by async block is not `Send` | ::: [..]spawn.rs:127:21 | 127 | T: Future + Send + 'static, | ---- required by this bound in | `tokio::task::spawn::spawn` | = help: within `impl std::future::Future`, the trait | `std::marker::Send` is not implemented for | `std::rc::Rc<&str>` note: future is not `Send` as this value is used across an await --> src/main.rs:10:9 | 7 | let rc = Rc::new("hello"); | -- has type `std::rc::Rc<&str>` which is not `Send` ... 10 | yield_now().await; | ^^^^^^^^^^^^^^^^^ await occurs here, with `rc` maybe | used later 11 | println!("{}", rc); 12 | }); | - `rc` is later dropped here }

我们会在下一节 Shared state 来更深入的探讨这个错误的特殊情况。

Store values(存储值)

我们现在将要实现 process 函数来处理发送过来的命令。我们使用 HashMap 来存储值。SET 命令将会插入数据到 HashMap ,GET 值会加载数据。另外,我们将会使用一个 loop 来接受每个连接的多个命令。

use mini_redis::{Connection, Frame}; use tokio::net::{TcpListener, TcpStream}; #[tokio::main] async fn main() { // 绑定 listener 到一个地址 let listener = TcpListener::bind("127.0.0.1:6379").await.unwrap(); loop { // 解构出来的第二个 item 包含一个新 connection 的一对 IP 和 port,这里将其忽略了 let (socket, _) = listener.accept().await.unwrap(); // 生成一个新任务,socket 的所有权被移动到了这个新任务里面,并在那里被处理。 tokio::spawn(async move { process(socket).await }); } } async fn process(socket: TcpStream) { use mini_redis::Command::{self, Get, Set}; use std::collections::HashMap; // 一个 `HashMap` 用来存储数据 let mut db = HashMap::new(); // `Connection` 让我们能够读写 redis **frames**(抽象的帧) 而不是 // byte streams(字节流). `Connection` 类型由 mini-redis 定义。 let mut connection = Connection::new(socket); // 使用 `read_frame` 来从`connection`接收一个`Command`。 while let Some(frame) = connection.read_frame().await.unwrap() { let response = match Command::from_frame(frame).unwrap() { Set(cmd) => { // 值被存储为 `Vec<u8>` db.insert(cmd.key().to_string(), cmd.value().to_vec()); Frame::Simple("OK".to_string()) } Get(cmd) => { if let Some(value) = db.get(cmd.key()) { // `Frame::Bulk` 期望数据是`Bytes` 类型的。 // 这个类型将会在教程的后面部分讨论。 // 现在`&Vec<u8>` 通过 `into()` 被转换成了 `Bytes` 。 Frame::Bulk(value.clone().into()) } else { Frame::Null } } cmd => panic!("unimplemented {:?}", cmd), }; // Write the response to the client connection.write_frame(&response).await.unwrap(); } }

让我们来试一试:

cargo run

另一个终端窗口执行:

cargo run --example hello-redis

出现了如下输出:

从服务端得到了值; result=Some(b"world")

我们现在可以获取和设置值,但是有一个问题:这些值在连接之间不共享。如果另一个套接字连接并尝试获取hello键,它将找不到任何东西。

在下一节中,我们将为所有套接字实现持久化数据。

Shared state

到目前为止,我们有一个 key-value server 在工作。但是,存在一个重大缺陷:状态不会在连接之间共享。我们将在本文中修复它。

Strategies (方案)

这里有两种不同的方式来在 Tokio 中分享状态。

-

使用

Mutex保护被分享的状态。 -

生成一个任务来管理状态并且使用消息传递来操作

一般来说你想要为简单的数据采用第一种方法,第二种方法用来应对需要像 I/O 原语这样的异步工作。在本章,被分享的状态是一个 HashMap 并且操作为 insert 和 get 。这两种操作都不是异步的,因此我们可以使用 Mutex 。

下一章再来介绍后一种方法。

Add bytes dependency (添加 bytes 依赖)

与使用 Vec<u8> 不同,Mini-Redis crate 使用了 bytes crate 中的 Bytes 。使用 Bytes 的目的是为网络编程提供一个健壮的字节数组结构体。Bytes 比 Vec<u8> 多的一个最大的特点是它实现了浅拷贝。换句话说,在 Bytes 实例上调用 clone() 不会拷贝底层的数据。相反,一个 Bytes 实例是一个底层数据的 rc(引用计数器)句柄。Bytes 类型与 Arc<Vec<u8>> 相似,但是多了些附加的功能。

为了引入 bytes 依赖,把下方的内容添加到你的 Cargo.toml 中的 [dependencies] 部分:

bytes = "1"

Initialize the HashMap (初始化 HashMap)

HashMap 将会被跨多任务(并且可能会是多个线程)共享。为了能够做到这点,它将会被 Arc<Mutex<_>> 包裹。

首先,方便起见,在 use 语句后加上下面的类型别名:

#![allow(unused)] fn main() { use bytes::Bytes; use std::collections::HashMap; use std::sync::{Arc, Mutex}; type Db = Arc<Mutex<HashMap<String, Bytes>>>; }

然后,改变 main 函数来初始化 HashMap 并且传递一个 Arc 句柄参数给 process 函数。使用 Arc 能够允许 HashMap 被多个任务并发地引用以及在多线程中运行。在整个 Tokio 中,这样的 Arc 句柄常见于用来引用一个提供了对某些共享状态的访问的值。

use tokio::net::TcpListener; use std::collections::HashMap; use std::sync::{Arc, Mutex}; #[tokio::main] async fn main() { let listener = TcpListener::bind("127.0.0.1:6379").await.unwrap(); println!("Listening"); let db = Arc::new(Mutex::new(HashMap::new())); loop { let (socket, _) = listener.accept().await.unwrap(); // Clone the handle to the hash map. let db = db.clone(); println!("Accepted"); tokio::spawn(async move { process(socket, db).await; }); } }

使用 std::sync::Mutex

请注意,用的是 std::sync::Mutex 来保护 HashMap 而不是 tokio::sync:Mutex 。一个常见的错误是无条件的在异步代码中使用 tokio::sync::Mutex 。异步锁是用来锁定跨 .await 调用的互斥锁。

一个同步的互斥锁在等待获取锁的时候会阻塞当前线程。所以反过来说,它会阻塞所在线程对其它任务的处理。但是,切换到 tokio::sync::Mutex 通常不能够有什么帮助,因为异步锁在内部也使用了同步锁。

有这样一个经验法则,只要锁竞争保持在一个较低的水准并且锁没有跨 .await 持有,那么在异步代码中使用同步锁也很好。另外,可以考虑使用 parking_log::Mutex 作为替代,它是比 std::sync::Mutex 更快的实现。

Update process() (更新 process())

这个函数不再初始化 HashMap 。相反,它接收一个共享的 HashMap 作为参数。它同样需要在使用前 lock 这个 HashMap 。请记住,HashMap 的值的类型现在是 Bytes (clone 它的代价非常低)了,所以也需要修改。

#![allow(unused)] fn main() { use tokio::net::TcpStream; use mini_redis::{Connection, Frame}; async fn process(socket: TcpStream, db: Db) { use mini_redis::Command::{self, Get, Set}; // Connection, provided by `mini-redis`, handles parsing frames from // the socket let mut connection = Connection::new(socket); while let Some(frame) = connection.read_frame().await.unwrap() { let response = match Command::from_frame(frame).unwrap() { Set(cmd) => { let mut db = db.lock().unwrap(); db.insert(cmd.key().to_string(), cmd.value().clone()); Frame::Simple("OK".to_string()) } Get(cmd) => { let db = db.lock().unwrap(); if let Some(value) = db.get(cmd.key()) { Frame::Bulk(value.clone()) } else { Frame::Null } } cmd => panic!("unimplemented {:?}", cmd), }; // Write the response to the client connection.write_frame(&response).await.unwrap(); } } }

Tasks, threads, and contention (任务、线程、竞争)

当锁竞争很小的时候,使用一个阻塞的锁来保护短临界区 是一种可接受的策略。当一个锁在被竞争,执行本任务的线程必须阻塞并且等待这个锁。这不仅仅会阻塞当前的任务,还会阻塞其他被调度到当前线程上的任务。

默认情况下,Tokio runtime 使用一个多线程调度器。任务被调度到被 runtime 管理的任意数量的线程上。如果计划执行大量任务,并且它们都需要访问互斥锁,那么就会出现竞争。另一方面,如果 current_thread runtime 风格被启用,那么互斥锁将永远不会被竞争。

current_threadruntime flavor 是一个轻量、单线程的运行时。当只生成少量任务和打开不多的 sockets 时它是一个不错的选择。举个例子,当在异步客户端库之上桥接一个同步 API 时,这种选择效果很好(比如用new 一个 current_thread runtime,然后在它之上用 block_on 执行异步代码)。

如果在同步锁上的竞争成为了一个问题,最好的解决方案是少量切换成 Tokio mutex。如果不采用前者方案,要考虑的选项有:

-

跑一个专门用来管理状态的任务,并且使用消息传递来共享状态。

-

分片锁。

-

重构代码来避开锁。

在我们目前的情况下,因为每个 key 都是独立的,所以分片锁的效果会很棒!为了做到这个,不能够只有一个单独的 Mutex<HashMap<_,_>> 实例,我们需要引入 N 个不同的实例:

#![allow(unused)] fn main() { type ShardedDb = Arc<Vec<Mutex<HashMap<String, Vec<u8>>>>>; fn new_sharded_db(num_shards: usize) -> ShardedDb { let mut db = Vec::with_capacity(num_shards); for _ in 0..num_shards { db.push(Mutex::new(HashMap::new())); } Arc::new(db) } }

接着,找到给定 key 的的位置变成了两步过程。第一步,用 key 来确定在哪一个hash map 分片。第二步在 HashMap 中找 key:

#![allow(unused)] fn main() { let shard = db[hash(key) % db.len()].lock().unwrap(); shard.insert(key, value); }

上面概述的简单实现需要使用固定数量的分片,并且一旦创建了 SharedDb 后分片的数量就不能改变了。dashmap crate 提供了一个更有经验验证的分片 hash map 实现。

Holding a MutexGuard across an .await (跨 .await 持有一个 MutexGuard)

你可能会写出像下面这样的代码:

#![allow(unused)] fn main() { use std::sync::{Mutex, MutexGuard}; async fn increment_and_do_stuff(mutex: &Mutex<i32>) { let mut lock: MutexGuard<i32> = mutex.lock().unwrap(); *lock += 1; do_something_async().await; } // 锁在这里超出作用域 }

当你尝试 spawn 一些东西来调用这个函数,你会遇到下面的错误信息:

#![allow(unused)] fn main() { error: future cannot be sent between threads safely --> src/lib.rs:13:5 | 13 | tokio::spawn(async move { | ^^^^^^^^^^^^ future created by async block is not `Send` | ::: /playground/.cargo/registry/src/github.com-1ecc6299db9ec823/tokio-0.2.21/src/task/spawn.rs:127:21 | 127 | T: Future + Send + 'static, | ---- required by this bound in `tokio::task::spawn::spawn` | = help: within `impl std::future::Future`, the trait `std::marker::Send` is not implemented for `std::sync::MutexGuard<'_, i32>` note: future is not `Send` as this value is used across an await --> src/lib.rs:7:5 | 4 | let mut lock: MutexGuard<i32> = mutex.lock().unwrap(); | -------- has type `std::sync::MutexGuard<'_, i32>` which is not `Send` ... 7 | do_something_async().await; | ^^^^^^^^^^^^^^^^^^^^^^^^^^ await occurs here, with `mut lock` maybe used later 8 | } | - `mut lock` is later dropped here }

这个错误会发生是因为 std::sync::MutexGuard 类型没有实现 Send trait 。这意味着你不能传递一个同步锁到另一个线程,另一个原因是 Tokio runtime 在每个 .await 调用时能够在线程间 move 一个任务。为了避免这个错误,你应该重构你的代码来让互斥锁的析构函数在 .await 之前就运行完毕。

#![allow(unused)] fn main() { // 这样就行了! async fn increment_and_do_stuff(mutex: &Mutex<i32>) { { let mut lock: MutexGuard<i32> = mutex.lock().unwrap(); *lock += 1; } // 锁在这里超出作用域 do_something_async().await; } }

值得注意的是,下面这样不能正常运作:

#![allow(unused)] fn main() { use std::sync::{Mutex, MutexGuard}; // This fails too. async fn increment_and_do_stuff(mutex: &Mutex<i32>) { let mut lock: MutexGuard<i32> = mutex.lock().unwrap(); *lock += 1; drop(lock); do_something_async().await; } }

这是因为编译器目前只是通过作用域信息来计算一个 future 是不是实现了 Send trait 。编译器未来有望被更新来支持显式的 drop,但是现在咱只能显式的加上作用范围。

注意,这里讨论的错误在上一节的 Send Bound - Spawning 也讨论过。

你不应该尝试通过某种方式生成一个不需要实现 Send 的任务来规避这个问题,因为如果任务正持有锁,而 Tokio 在 .await 处暂停了你的任务,一些其它的任务可能会被调度到同样的线程上,并且其他任务也可能尝试获取锁,这会导致死锁,因为等待锁的任务会阻塞当前线程,这也就阻止了持有锁的任务释放锁。

我们下面将要讨论一些解决这个错误信息的方法:

Restructure your code to not hold the lock across an .await (重构你的代码来让锁不再跨 .await 持有)

我们已经在上面的片段中看到了一个例子,但是还有一些更鲁棒的解决方式。举个例子,你可以把互斥锁包装在一个结构体内,并且只将互斥锁锁定在该结构体上的非异步方法中。细节如下:

#![allow(unused)] fn main() { use std::sync::Mutex; struct CanIncrement { mutex: Mutex<i32>, } impl CanIncrement { // This function is not marked async. fn increment(&self) { let mut lock = self.mutex.lock().unwrap(); *lock += 1; } } async fn increment_and_do_stuff(can_incr: &CanIncrement) { can_incr.increment(); do_something_async().await; } }

这种模式保证了你不会进入到 Send 错误中去,因为 mutex guard 没有出现在异步函数的任何地方,它在自己的同步函数结束时已经被释放了。

Spawn a task to manage the state and use message passing to operate on it(生成一个任务来管理状态,并且通过消息传递来操作)

这是本章节最开始提到的两种方法中的第二种,并且它常常在共享的资源是 I/O 资源的时候被采用。有关更多详细信息,请参阅下一章。

Use Tokio's asynchronous mutex(使用 Tokio 异步锁)

Tokio 提供的 tokio::sync:Mutex 类型也能在这使用。Tokio mutex 的主要特点是它能够被跨 .await 持有而不会出现任何问题。换而言之,使用一个异步锁的开销肯定是大于使用一个普通的互斥锁的,通常最好使用另外两种方法之一。

#![allow(unused)] fn main() { use tokio::sync::Mutex; // note! This uses the Tokio mutex // This compiles! // (but restructuring the code would be better in this case) async fn increment_and_do_stuff(mutex: &Mutex<i32>) { let mut lock = mutex.lock().await; *lock += 1; do_something_async().await; } // lock goes out of scope here }

Channels

现在我们已经了解了一些关于 Tokio 的并发,让我们把它们应用到客户端侧吧。把我们先前写的服务端的代码移动到一个显式的二进制文件里去:

mkdir src/bin

mv src/main.rs src/bin/server.rs

然后创建一个新的 binary 来放我们的客户端代码:

#![allow(unused)] fn main() { touch src/bin/client.rs }

在这个文件中,我们将会写关于本节的代码。无论何时你想运行它,请先启动 server 端:

cargo run --bin server

然后在另一个终端窗口:

cargo run --bin client

话都说到这个份上了,来让我们开始 code 吧!

比如说我门想要运行两个并发的 Redis commands。我们可以为每个 command 生成一个任务。然后两个命令就能并发啦~

一开始啊,我们可能会想到下面这种方式:

use mini_redis::client; #[tokio::main] async fn main() { // Establish a connection to the server let mut client = client::connect("127.0.0.1:6379").await.unwrap(); // Spawn two tasks, one gets a key, the other sets a key let t1 = tokio::spawn(async { let res = client.get("hello").await; }); let t2 = tokio::spawn(async { client.set("foo", "bar".into()).await; }); t1.await.unwrap(); t2.await.unwrap(); }

不幸的是呢,编译器阻止了我们继续,因为两个任务都需要用某种方式访问 client 。由于

Client 并没有实现 Copy trait ,所以如果没有一些代码来促成 client 的共享是不能被编译通过的。再说,Client::set 需要 &mut self ,这意味着调用它的时候需要独占 Client 的访问。我们可以为每个连接打开一个任务,但是这并不理想。因为 .await 需要带着锁被调用,所以我们不能使用 std::sync::Mutex 。我们可以使用 tokio::sync::Mutex ,但是这会导致同一时间只能有一个请求(即 singleflight 单飞)。如果客户端实现了 pipelining ,一个异步锁会导致连接的低利用率。

Message passing (消息传递)

实践答案是使用消息传递!这种模式包含生成一个专门的任务来管理 client 资源。任何想要发起请求的任务都要发送消息给这个 client 任务。client 任务的角色相当于代理人,它会代表发送者(sender)来发送请求(request),并把响应(response)发回给发送者(sender)。

采用这种策略,需要创建一个单独的连接。管理 client 的任务能够独占访问权限以便调用 set 和 get 。此外, channel 以缓冲区的方式工作。当 client 任务正忙的时候,任务可能会被发送到 client 。一旦 client 空闲了,可以处理新请求了,它会从 channel 拉去下一个请求。这种方式可以有更好的吞吐量,并且能够被拓展,支持连接池。

Tokio's channel primitives (Tokio 的通道原语)

Tokio 提供了 一些 channel ,每个都有不一样的目的。

-

mpsc:多生产者,单消费者的 channel。可以发送许多值。

-

oneshot:单生产者,单消费者的 channel。可以发送单个值。

-

broadcast:多生产者,多消费者。可以发送许多值,每个接收者都能看到每个值。

-

watch:单生产者,多消费者。可以发送许多值,但是不会保留历史值。接收者只能看到最新的值。

如果你需要一个多生产者多消费者的 channel,其中每条消息只能由所有现有消费者中的一个接收,那么你可以使用 async-channel crate。异步 Rust 之外还有同步的 channel,比如 std::sync::mpsc 和 crossbeam::channel。这些 channel 都会在等待消息的时候阻塞线程,这意味着它们不适合用在异步代码中。

在这块内容里,我们会使用 mpsc 和 oneshot 。其他类型的 channel 会在之后的内容中探索。本节内容的完整代码在这里 。

Define the message type (定义消息类型)

在许多使用消息传递的场景下,接收消息的任务会响应多条命令。在我们的场景下,任务将会响应 GET 和 SET 命令。为了模拟这个,我们先定义一个 Command enum 。

#![allow(unused)] fn main() { use bytes::Bytes; #[derive(Debug)] enum Command { Get { key: String, }, Set { key: String, val: Bytes, } } }

Create the channel (创建通道)

在 main 函数中,我们创建一个 mpsc channel。

use tokio::sync::mpsc; #[tokio::main] async fn main() { // 创建一个新的 mpsc ,并给它的最大容量设置为 32。 let (tx, mut rx) = mpsc::channel(32); // ... Rest comes here }

mpsc 用来发送命令给管理 redis connection 的任务。多生产者的容量允许消息可以从多个任务中发送。创建 channel 会返回两个值,一个 sender(习惯上命名为 tx) 和一个 receiver (习惯上命名为 rx)。这俩句柄是分开使用的,它们可能会被移动到不同的任务中去。

这里的 channel 创建时指定了 32 个容量。如果消息发的比收的快,那么 channel 会把没来得及被接收的消息存起来。一旦 channel 中的 32 个位置都被消息填满了,这时候再调用 send(...).await 将会 sleep 直到有 1 个消息被 receiver 拿走去消费。

从多个任务发送消息是通过 clone Sender 做到的。例如:

use tokio::sync::mpsc; #[tokio::main] async fn main() { let (tx, mut rx) = mpsc::channel(32); let tx2 = tx.clone(); tokio::spawn(async move { tx.send("sending from first handle").await; }); tokio::spawn(async move { tx2.send("sending from second handle").await; }); while let Some(message) = rx.recv().await { println!("GOT = {}", message); } }

两条消息都被发送到了单个 Receiver 句柄。在 mpsc channel 中克隆 receiver 是不被允许的。

当每个 Sender 超出作用域或者因为其他原因被 drop 了,就不再能往这个 channel 发送更多消息了。此时,在 Receiver 上调用 recv 将会返回 None,这意味着所有的 sender 都不在了,channel 被关闭了。

在我们的场景下,管理 redis connection 的任务知道一旦 channel 被关闭,就得关闭 redis connection,因为 connection 不会再被使用了。

Spawn manager task (生成管理者任务)

接下来,生成一个任务来处理来自 channel 的消息。首先,一个对 redis 的客户端连接会被建立。然后,受到的命令会通过 redis connection 被发送。

#![allow(unused)] fn main() { use mini_redis::client; // The `move` keyword is used to **move** ownership of `rx` into the task. let manager = tokio::spawn(async move { // Establish a connection to the server let mut client = client::connect("127.0.0.1:6379").await.unwrap(); // Start receiving messages while let Some(cmd) = rx.recv().await { use Command::*; match cmd { Get { key } => { client.get(&key).await; } Set { key, val } => { client.set(&key, val).await; } } } }); }

现在,更新这两个任务以通过通道发送命令,而不是直接在Redis连接上发出它们。

#![allow(unused)] fn main() { // The `Sender` handles are moved into the tasks. As there are two // tasks, we need a second `Sender`. let tx2 = tx.clone(); // Spawn two tasks, one gets a key, the other sets a key let t1 = tokio::spawn(async move { let cmd = Command::Get { key: "hello".to_string(), }; tx.send(cmd).await.unwrap(); }); let t2 = tokio::spawn(async move { let cmd = Command::Set { key: "foo".to_string(), val: "bar".into(), }; tx2.send(cmd).await.unwrap(); }); }

在 main 函数的底部,我们 .await 这些 JoinHandle 来确保commands 能够在进程退出前完全完成。

#![allow(unused)] fn main() { t1.await.unwrap(); t2.await.unwrap(); manager.await.unwrap(); }

Receive responses (接收响应)

最后一步是从管理器任务接收响应(response)。GET command 需要获取 value 并且 SET command 需要知道它的操作是否成功完成。

为了传递响应,我们使用一个 oneshot channel。oneshot channel 是一个单生产者,单消费者的 channel,针对发送单一值进行了优化。在我们的场景下,响应就是单一值。

与 mpsc 类似,oneshot::channel() 返回一个 sender 和一个 receiver 句柄。

#![allow(unused)] fn main() { use tokio::sync::oneshot; let (tx, rx) = oneshot::channel(); }

不像 mpsc ,oneshot 不需要指定容量,因为它的容量始终是 1。另外,oneshot 的两个句柄都不能被 clone。

为了从管理器任务接收响应,在发送一个 command 之前,要先创建一个 oneshot channel。oneshot 的 Sender 会被包含在发给管理器任务中的 command 中。而 Receiver 用来接收管理器任务用 oneshot 的 Sender 发送的消息。

首先,改变 Command 来包含 Sender 。方便起见,用了一个类型别名来使用 Sender。

#![allow(unused)] fn main() { use tokio::sync::oneshot; use bytes::Bytes; /// Multiple different commands are multiplexed over a single channel. #[derive(Debug)] enum Command { Get { key: String, resp: Responder<Option<Bytes>>, }, Set { key: String, val: Bytes, resp: Responder<()>, }, } /// Provided by the requester and used by the manager task to send /// the command response back to the requester. type Responder<T> = oneshot::Sender<mini_redis::Result<T>>; }

现在,改变发送 command 的任务,让它包含一个 oneshot::Sender。

#![allow(unused)] fn main() { let t1 = tokio::spawn(async move { let (resp_tx, resp_rx) = oneshot::channel(); let cmd = Command::Get { key: "hello".to_string(), resp: resp_tx, }; // Send the GET request tx.send(cmd).await.unwrap(); // Await the response let res = resp_rx.await; println!("GOT = {:?}", res); }); let t2 = tokio::spawn(async move { let (resp_tx, resp_rx) = oneshot::channel(); let cmd = Command::Set { key: "foo".to_string(), val: "bar".into(), resp: resp_tx, }; // Send the SET request tx2.send(cmd).await.unwrap(); // Await the response let res = resp_rx.await; println!("GOT = {:?}", res); }); }

在 oneshot::Sender 上的 send 调用是立即完成的,不需要一个 .await 。这是因为 oneshot channel 上的 send 总是立即返回 succeed 或者 fail ,而不需要任何形式的等待。

当接收端被 drop 时,往一个 oneshot channel 发送一个值会返回 Err 。这表示接收端不再对结果感兴趣了。在我们的假设中,接收端(想发命令的任务)不再对 response(管理器任务返回的结果) 感兴趣的情况是可接受的。所以通过 resp.send(...) 返回的 Err 就没必要处理了。

可以在这里看到完整代码。

Backpressure and bounded channels (背压和有界的通道)

这里的小标题我不会翻译 :(

每当引入并发(cibcurrency)和队列(queuing)的时候,确保队列有界且系统能优雅的处理负载是非常重要的。无界的队列将会导致可用内存耗尽,并且还会导致系统陷入无法预测的失败中。

Tokio 会注意避免隐式队列。事实上很大一部分是因为异步操作是惰性的(这在前面提到过,这也是 rust 与其它实现 async/await 的语言的不同之处)。思考下下面的情况:

#![allow(unused)] fn main() { loop { async_op(); } }

如果异步操作迫切的希望被运行,loop 循环在没有确保先前的操作完成的情况下,反复将新的 async_op 排进一个队列来运行,这会导致隐式的无界队列。基于回调(callback)和基于勤奋 future(rust 是惰性 future)的系统会特别容易受到这种影响。

然而~,使用 Tokio 和异步 Rust ,上述片段根本就不会被运行。这是因为 .await 从未被调用。如果上述片段改成使用 .await ,那么这个循环就会在重新开始之前等待操作执行完毕。

#![allow(unused)] fn main() { loop { // 在 `async_op` 完成之前是不会重新开始循环的 async_op().await; } }

并发和队列必须被显式地引入。这么做的方法包括:

-

tokio::spawn -

select! -

join! -

mpsc::channel

当需要这么做的时候,请确保并发的总量是有界的(不要无限制的创建 task)。举个例子,当写一个 TCP accept loop 的时候,确保打开的 socket 总数是有界的。当使用 mpsc::channel时,选择一个能够被管理的容量限度(容量不要超出实际承受能力)。指定有界值是特定于应用的。

小心和选择好的界限是编写可靠的Tokio应用程序的重要组成部分。

I/O

Tokio 的 I/O 操作大致与 std 中的相同,但是是异步的。这有一个为读取而生的 trait AsyncRead 和一个为写入而生的 trait AsyncWrite 。一些特定的类型恰当的实现了这些 trait(TcpStream, File, Stdout)。AsyncRead 和 AsyncWrite 也被一些像 Vec<u8> 和 &[u8] 这样的数据结构实现了。这允许在需要 reader 或 writer 的地方使用字节数组。

本章将会覆盖基础的 Tokio I/O 读写并且通过几个例子来说明。下一章将会给出一个更加高级的 I/O 示例。

AsyncRead and AsyncWrite

这两个 trait 提供了异步读写字节流的工具。在这些 trait 上的方法通常不会直接调用,就好像你不会手动从 Future 调用 poll 方法。相反,我们都是通过 AsyncReadExt and AsyncWriteExt 提供的实用方法来使用它们。

让我们简略的看一下它俩的几个方法。这些方法都是 async ,所以都必须用 .await 来使用。

async fn read()

AsyncReadExt::read 提供了一个异步方法来读取数据到一个 buffer,返回读取的字节数。

Note: 当 read() 返回了 Ok(0) ,这标志着 stream 关闭了。任何对 read() 的进一步调用都会立即返回 Ok(0) 。对 TcpStream 实例来说,这标志着 socket 的 the read half 关闭了。

use tokio::fs::File; use tokio::io::{self, AsyncReadExt}; #[tokio::main] async fn main() -> io::Result<()> { let mut f = File::open("foo.txt").await?; let mut buffer = [0; 10]; // read up to 10 bytes let n = f.read(&mut buffer[..]).await?; println!("The bytes: {:?}", &buffer[..n]); Ok(()) }

async fn read_to_end()

AsyncReadExt::read_to_end 会从 stream 读取所有的字节直到 EOF。

use tokio::io::{self, AsyncReadExt}; use tokio::fs::File; #[tokio::main] async fn main() -> io::Result<()> { let mut f = File::open("foo.txt").await?; let mut buffer = Vec::new(); // read the whole file f.read_to_end(&mut buffer).await?; Ok(()) }

async fn write()

AsyncWriteExt::write 把一个 buffer 写入到 writer,返回写入的字节数。

use tokio::io::{self, AsyncWriteExt}; use tokio::fs::File; #[tokio::main] async fn main() -> io::Result<()> { let mut file = File::create("foo.txt").await?; // Writes some prefix of the byte string, but not necessarily all of it. let n = file.write(b"some bytes").await?; println!("Wrote the first {} bytes of 'some bytes'.", n); Ok(()) }

async fn write_all()

AsyncWriteExt::write_all 把整个 buffer 写入 writer,与上面那个不一样,这哥们就不返回写入的字节数了。

use tokio::io::{self, AsyncWriteExt}; use tokio::fs::File; #[tokio::main] async fn main() -> io::Result<()> { let mut file = File::create("foo.txt").await?; file.write_all(b"some bytes").await?; Ok(()) }

这两个特征都包括许多其他有用的方法。有关完整的方法列表,请参阅API文档。

Helper functions (辅助函数)

此外,就像 std, tokio::io 模块包含了一些有用的工具函数以及用于处理 standard input、 standard output 和 standard error 的API。例如,tokio::io::copy 异步的将 reader 的全部内容 copy 到一个 writer 。

use tokio::fs::File; use tokio::io; #[tokio::main] async fn main() -> io::Result<()> { let mut reader: &[u8] = b"hello"; let mut file = File::create("foo.txt").await?; io::copy(&mut reader, &mut file).await?; Ok(()) }

请注意,这种用法体现了 &[u8] 也实现 AsyncRead 的事实。

Echo server (回声服务)

让我们做些玩意儿来练习下异步I/O。我们将要写一个回声服务。

这个回声服务要绑定在一个 TcpListener 并且在一个 loop 中接收入站连接。对每个入站连接来说,数据从 socket 中读取并立即写回 socket。客户端发送数据到服务端,并接收回相同的数据。

我们将会用两种不同的方案来实现两次回声服务。

Using io::copy()

开始,我们将用 io::copy 实用工具来实现 echo 逻辑。

你可以写在一个新的 binary 文件中:

touch src/bin/echo-server-copy.rs

可以通过以下方式启动(或只是检查编译):

cargo run --bin echo-server-copy

我们能够使用一个标准的命令行工具,比如 telnet 来测试我们的回声服务,或者通过写一个简单的客户端,就像在 tokio::net::TcpStream 文档中找到的那个一样。

这是一个 TCP server 并且需要一个 accept loop。一个新的任务被生成来处理每个接收到的 socket 。

use tokio::io; use tokio::net::TcpListener; #[tokio::main] async fn main() -> io::Result<()> { let listener = TcpListener::bind("127.0.0.1:6142").await?; loop { let (mut socket, _) = listener.accept().await?; tokio::spawn(async move { // Copy data here }); } }

就像前面说的,这个工具函数接收一个 reader 参数和一个 writer 参数,并且将数据从一个 copy 到另一个中。然而啊,我们只有一个 TcpStream ,这单个值同时实现了 AsyncRead 和 AsyncWrite 。可是由于 io::copy 对 reader 和 writer 都要求 &mut ,这 socket 不能同时作为放到这两个参数上。

#![allow(unused)] fn main() { // 这是无法编译的 io::copy(&mut socket, &mut socket).await }

Splitting a reader + writer

为了解决这个难题,我们必须把 socket 分离成一个 reader 句柄和一个 writer 句柄。拆分 reader/writer 组合的最佳方法是使用 io::split。

任何同时实现了 reader + writer 的类型都能够使用 io::split 实用工具来拆分。这个函数接收单个的值并返回分离的 reader 和 writer 句柄。这两个句柄可以被独立使用,包括分别在两个单独的任务中使用。

举个例子,echo 客户端可以像这样并发处理读写:

use tokio::io::{self, AsyncReadExt, AsyncWriteExt}; use tokio::net::TcpStream; #[tokio::main] async fn main() -> io::Result<()> { let socket = TcpStream::connect("127.0.0.1:6142").await?; let (mut rd, mut wr) = io::split(socket); // Write data in the background tokio::spawn(async move { wr.write_all(b"hello\r\n").await?; wr.write_all(b"world\r\n").await?; // 有时候,rust 的类型推断器需要一点点的帮助 Ok::<_, io::Error>(()) }); let mut buf = vec![0; 128]; loop { let n = rd.read(&mut buf).await?; if n == 0 { break; } println!("GOT {:?}", &buf[..n]); } Ok(()) }

因为 io::split 支持任何实现了 AsyncRead + AsyncWrite 的值,并返回独立的句柄,io::split 在内部使用了一个 Arc 和 一个 Mutex (这意味着会有蛮大的开销)。如果 socket 是 TcpStream 的情况就能避免这种开销。TcpStream 提供了两个专门的函数(TcpStream::split 和 into_split)。

TcpStream::split 接收一个 &mut TcpStream 并返回一个 reader 和 一个 writer 句柄。正因为使用的是引用,所以这两个句柄必须跟 split() 调用待在同一任务中。虽然有前面这个限制,但是它的这种专门实现是零开销的,没有 Arc 也没有 Mutex 。TcpStream 也提供了 into_split 来支持处理可跨任务使用的场景,开销缩减到了只有一个 Arc。

因为 io::copy() 调用是跟持有 TcpStream 的任务是同一个任务(跟上面那段代码中的情况不同,上面的代码的 rd 跟 wr 在不同的任务中),这就意味着我们完全可以使用 TcpStream::split 。在 server 处理 echo 逻辑的任务变成了下面这样:

#![allow(unused)] fn main() { tokio::spawn(async move { let (mut rd, mut wr) = socket.split(); if io::copy(&mut rd, &mut wr).await.is_err() { eprintln!("failed to copy"); } }); }

可以在这里找到完整代码。

Manual copying (手动 copy)

现在,来看一下我们要如何通过手动 copy data 来写 echo server。为了做到这点,我们使用 AsyncReadExt::read 和 AsyncWriteExt::write_all 。

完整的 server 代码是这样:

use tokio::io::{self, AsyncReadExt, AsyncWriteExt}; use tokio::net::TcpListener; #[tokio::main] async fn main() -> io::Result<()> { let listener = TcpListener::bind("127.0.0.1:6142").await?; loop { let (mut socket, _) = listener.accept().await?; tokio::spawn(async move { let mut buf = vec![0; 1024]; loop { match socket.read(&mut buf).await { // Return value of `Ok(0)` signifies that the remote has // closed Ok(0) => return, Ok(n) => { // Copy the data back to socket if socket.write_all(&buf[..n]).await.is_err() { // Unexpected socket error. There isn't much we can // do here so just stop processing. return; } } Err(_) => { // Unexpected socket error. There isn't much we can do // here so just stop processing. return; } } } }); } }

(你可以把这段代码放到 src/bin/echo-server.rs 并用 cargo run --bin echo-server 启动它)

我是 arch linux :

yay -S netcat

echo 你好 | nc 127.0.0.1 6142

让我们分析一下:首先,因为使用了 AsyncRead 和 AsyncWrite ,所以 extension traits (AsyncReadExt 和AsyncWriteExt)必须被引入。

#![allow(unused)] fn main() { use tokio::io::{self, AsyncReadExt, AsyncWriteExt}; }

Allocating a buffer (申请缓冲区)

这种策略是为了从 socket 读取一些数据到缓冲区,然后再把缓冲区的内容写回 socket。

#![allow(unused)] fn main() { let mut buf = vec![0;1024]; }

显式地避免了栈上缓冲区。回顾一下之前 ,我们注意到所有的跨 .await 调用的数据都得由任务本身存储。而在这个场景, buf 被用来跨 .await 。所有的任务数据被存储在同一个内存块。你可以把它想象成一个 enum ,enum 内的变量都是需要为一个特定的 .await 存储的数据。

如果这个 buf 是一个栈数组,每个被生成的用来接受 socket 的任务的内部结构可能看起来会像这样:

#![allow(unused)] fn main() { struct Task { // internal task fields here task: enum { AwaitingRead { socket: TcpStream, buf: [BufferType], }, AwaitingWriteAll { socket: TcpStream, buf: [BufferType], } } } }

如果一个栈数组被用来当做 buffer type,它将会被内联在任务结构体中。这会导致任务结构体非常庞大。另外,缓冲区大小通常是 page size (Modern hardware and software tend to load data into RAM (and transfer data from RAM to disk) in discrete chunk called pages)。这反过来又会使任务的大小变得尴尬:$page-size + 几个字节。

Linus 有一篇吐槽贴说:

Just do the math. I've done it. 4kB is good. 8kB is borderline ok. 16kB or more is simply not acceptable.

所以 linux 的 page size 应该会控制在 16kB 以内。

编译器优化 async blocks 的布局比优化一个 basic enum 要多很多。实际上,变量不会像 enum 所要求的那样在枚举变体之间移动。但是,任务结构体的大小至少与最大变量一样大。

正因如此,为 buffer 使用一个专门的内存分配通常是更有效的(这里是 Vector)。

Handling EOF (处理 EOF)

当 TCP stream 读的那一半句柄关闭了,再去调用 read() 会返回 Ok(0) 。在这种时候退出 read loop 是很重要的。忘记在 EOF 的时候退出 read loop 是一个常见的 bug 来源。

#![allow(unused)] fn main() { loop { match socket.read(&mut buf).await { // Return value of `Ok(0)` signifies that the remote has // closed Ok(0) => return, // ... other cases handled here } } }

忘记退出 read loop 通常会导致 100% CPU占用的无限循环。这是因为 socket 关闭后,socket.read() 会立即返回,循环就会永远的重复下去。

完整代码看这里

Framing

我们接下来将会应用我们在 I/O 章节的所学,并实现 Mini-Redis 的框架层(framing layer,或许应该叫帧层) 。Framing 是获取 byte stream 并转化成 a stream of frames(帧) 的过程。一个 frame (帧) 是两个对等端(此处应该指代 client and server)之间传输数据的单位。Redis protocal frame 定义如下:

#![allow(unused)] fn main() { use bytes::Bytes; enum Frame { Simple(String), Error(String), Integer(u64), Bulk(Bytes), Null, Array(Vec<Frame>), } }

注意 Frame 是如何包含没有任何语义的数据的, Command 解析和实现发生再更高级的层,而不在 Frame。

对于 HTTP 来说,一个 frame 可能看起来像这样:

#![allow(unused)] fn main() { enum HttpFrame { RequestHead { method: Method, uri: Uri, version: Version, headers: HeaderMap, }, ResponseHead { status: StatusCode, version: Version, headers: HeaderMap, }, BodyChunk { chunk: Bytes, }, } }

为了实现 Mini-Redis 的 frame,我们将会实现一个 Connecton 结构来包装一个 TcpStream 和 reads/writes mini_redis::Frame values。

#![allow(unused)] fn main() { use tokio::net::TcpStream; use mini_redis::{Frame, Result}; struct Connection { stream: TcpStream, // ... other fields here } impl Connection { /// Read a frame from the connection. /// /// Returns `None` if EOF is reached pub async fn read_frame(&mut self) -> Result<Option<Frame>> { // implementation here } /// Write a frame to the connection. pub async fn write_frame(&mut self, frame: &Frame) -> Result<()> { // implementation here } } }

可以在这里 找到 Redis wire protocal 的细节。完整的 Connection 代码在这里 。

Buffered reads (带缓冲地读)

read_frame 方法在返回前会等待一个完整的 frame 被接收。单个 TcpStream::read() 调用可能会返回一个任意数量的数据。这个数据可能是一个完整的 frame、一个不完整 frame 或者多个 frame。如果接收到了一个不完整的 frame,数据会被放入 buffer 并且会继续从 socket 读更多数据。如果接收到了多个 frame,第一个帧会被返回,剩下的数据会被放入 buffer 直到下次 read_frame 调用。

为了实现这个, Connection 需要一个 read buffer 字段。数据从 socket 被读入这个 read buffer。当一个帧被解析,相对应的数据会从 buffer 中被移除。

我们将会用 BytesMut 作为 buffer type。它是一个可变版本的 Bytes 。

#![allow(unused)] fn main() { use bytes::BytesMut; use tokio::net::TcpStream; pub struct Connection { stream: TcpStream, buffer: BytesMut, } impl Connection { pub fn new(stream: TcpStream) -> Connection { Connection { stream, // Allocate the buffer with 4kb of capacity. buffer: BytesMut::with_capacity(4096), } } } }

下面,我们实现 read_frame() 方法。

#![allow(unused)] fn main() { use tokio::io::AsyncReadExt; use bytes::Buf; use mini_redis::Result; pub async fn read_frame(&mut self) -> Result<Option<Frame>> { loop { // Attempt to parse a frame from the buffered data. If // enough data has been buffered, the frame is // returned. if let Some(frame) = self.parse_frame()? { return Ok(Some(frame)); } // There is not enough buffered data to read a frame. // Attempt to read more data from the socket. // // On success, the number of bytes is returned. `0` // indicates "end of stream". if 0 == self.stream.read_buf(&mut self.buffer).await? { // The remote closed the connection. For this to be // a clean shutdown, there should be no data in the // read buffer. If there is, this means that the // peer closed the socket while sending a frame. if self.buffer.is_empty() { return Ok(None); } else { return Err("connection reset by peer".into()); } } } } }

让我们来分析一下它。 read_frame 方法操作了一个 loop。首先,self.parse_frame() 被调用。它会尝试从 self.buffer 解析 redis frame。如果 self.buffer 里的数据足够解析出一个 frame,那么这个解析出来的 frame 会从 read_frame() 返回。如果数据不够解析成一个 frame,我们就尝试从 socket 读取更多数据到 buffer。在读取更多数据后循环会重新开始, parse_frame() 会被再次调用,如此往复。这次,如果接收到了足够的数据,解析可能就会成功了。

当从 stream 读取的时候,返回了一个 0 表示没有更多数据可以从对端接收了。如果这时候 read buffer 中还留有数据,这表示接收到的是个不完整的 frame 并且对端被意外中断了。这是一个错误条件,我们返回一个 Err 。

The Buf trait

当从 stream 读取的时候, read_buf 被调用了。我们这个版本的 read function 带了一个参数,要求实现 bytes crate 中的 BufMut。

首先,考虑怎样用 read() 实现相同的 read loop 。Vec<u8> 能够作为 BytesMut 的替代。

#![allow(unused)] fn main() { use tokio::net::TcpStream; pub struct Connection { stream: TcpStream, buffer: Vec<u8>, cursor: usize, } impl Connection { pub fn new(stream: TcpStream) -> Connection { Connection { stream, // Allocate the buffer with 4kb of capacity. buffer: vec![0; 4096], cursor: 0, } } } }

然后是我们在 Connection 的 read_frame() 函数:

#![allow(unused)] fn main() { use mini_redis::{Frame, Result}; pub async fn read_frame(&mut self) -> Result<Option<Frame>> { loop { if let Some(frame) = self.parse_frame()? { return Ok(Some(frame)); } // Ensure the buffer has capacity if self.buffer.len() == self.cursor { // Grow the buffer self.buffer.resize(self.cursor * 2, 0); } // Read into the buffer, tracking the number // of bytes read let n = self.stream.read( &mut self.buffer[self.cursor..]).await?; if 0 == n { if self.cursor == 0 { return Ok(None); } else { return Err("connection reset by peer".into()); } } else { // Update our cursor self.cursor += n; } } } }

当使用字节数组和 read 时,我们也必须维护一个 cursor(用来定位当前有效数据的位置)来跟踪已经有多少数据被放入了 buffer 。我们必须确保传递 buffer 的空的部分(cursor 后面的那些位置)给 read(),否则会覆盖掉已经塞入 buffer 的数据。如果我们的 buffer 被填满了,我们还必须为 buffer 扩容来保证可以保持读取。在 parse_frame() (没包含在上面),我们需要解析 self.buffer[..self.cursor] 中包含的数据。

因为将 byte array 和 cursor 配对是非常常见的,所以 bytes crate 提供了一个抽象来代表一个 byte array 和一个 cursor 。Buf trait 可以从能被 read 的数据实现。Buf trait 可以从能被 write 的数据实现。当传递一个 T: BufMut 给 read_buf() ,这个 buffer 内部的 cursor 会被 read_buf 自动更新。正因如此,我们这个版本的 read_frame 不需要管理自己的 cursor 。

此外,当使用 Vec<u8> 的时候,buffer 必须被初始化。vec![0;4096] 这个宏申请了一个 4k 字节的数组并且往 Vector 中的每个条目写了 0 。这个初始化过程不是免费的。当使用 BytesMut 和 BufMut 的时候,容量是不需要初始化的(这个特性棒:D)。BytesMut 这个抽象会阻止我们从未初始化的内存中进行读,这使得我们避开了初始化的步骤。

Parsing(解析)

现在,让我们瞅瞅看 parse_frame() 函数。解析由两个步骤完成。

-

确保缓冲了一个完整的 frame 并找到这个 frame 的索引位置。

-

解析这个 frame。

mini-redis crate 为以上两步都提供了一个函数:

-

Frame::check -

Frame::parse

我们还将复用 Buf 抽象来提供帮助。一个 Buf 被传递进 Frame::check 。当 check 函数迭代传进来的这个 buffer 的时候,内部的 cursor 会被推进。当 check 返回,这个 Buf 内部的 cursor 会指向 frame 的末尾。

对于 Buf 类型,我们会使用 std::io::Cursor<&[u8]> 。

#![allow(unused)] fn main() { use mini_redis::{Frame, Result}; use mini_redis::frame::Error::Incomplete; use bytes::Buf; use std::io::Cursor; fn parse_frame(&mut self) -> Result<Option<Frame>> { // 创建一个 `T: Buf`,Buf trait 在上面被引入了 // self.buffer 是一个 `BytesMut`,它实现了 Deref<Target = [u8]> // 因此能当 [u8] 使 let mut buf = Cursor::new(&self.buffer[..]); // Check whether a full frame is available match Frame::check(&mut buf) { Ok(_) => { // Get the byte length of the frame let len = buf.position() as usize; // Reset the internal cursor for the // call to `parse`. buf.set_position(0); // Parse the frame let frame = Frame::parse(&mut buf)?; // Discard the frame from the buffer self.buffer.advance(len); // Return the frame to the caller. Ok(Some(frame)) } // Not enough data has been buffered Err(Incomplete) => Ok(None), // An error was encountered Err(e) => Err(e.into()), } } }

完整的 Frame::check 函数可以在这里找到。我们的教程不会完全覆盖到它。

需要注意的相关事项是 Buf 的 “byte iterator” 样式 API 被使用了。这些 API 被用来获取数据并推进内部的 cursor 。举个例子,为了操作一个 frame,首个字节被检查来决定这个 frame 的类型。这个被使用的函数是 Buf::get_u8 ,它会获取当前 cursor 的位置上的一个字节并且推 cursor 一个单位。

Buf 还有很多更有用的方法。可以去 API docs 看更多细节。

Buffered writes(带缓冲地写)

framing 的另外一半 API 是 write_frame(frame) 函数。这个函数会把一个完整的 frame 写入到 socket 。为了最小化 write 系统调用的次数,写入操作都会被缓冲(buffered)。一个 write buffer 会被维护并且在往 socket 写入之前, frame 都会被 encode 到这个 buffer。然而,不同于 read_frame() ,在写入 socket 之前,并不总是会缓冲一整个 frame 。

思考一下有一个批量 frame 的流 (a bulk stream frame),被写入的值是 Frame::Bulk(Bytes) 。bulk frame 的报文格式是 frame 头是一个 $ 字符,然后跟着等同于数据字节数的长度,最后是数据本身。大部分 frame 都是 Bytes 的内容。如果数据很庞大,把它 copy 到一个中间缓冲区的开销会很大(这就是上一段末尾提到的)。

为了实现带缓冲的写入操作,我们将会使用 BufWriter struct 。这个结构体使用 T: AsyncWrite 来初始化(BufWriter::new(T),这个 T 得是 AsyncWrite),并且它本身也实现了 AsyncWrite 。当 write 在 BufWriter 上被调用,write 并不会直接作用到内部的 writer 上,而是作用到一个内部的 buffer 上。当这个 buffer 满了后,buffer 的内容会被刷到内部的 writer 上,同时清空这个 buffer 。我们还会有一些优化允许在某些情况下绕过缓冲区(上一段提到的情况)。

我们不会尝试把 write_frame() 的完整实现作为教程的一部分。所以完整实现请看这里。

首先, Connection 结构体需要改变成如下:

#![allow(unused)] fn main() { use tokio::io::BufWriter; use tokio::net::TcpStream; use bytes::BytesMut; pub struct Connection { stream: BufWriter<TcpStream>, buffer: BytesMut, } impl Connection { pub fn new(stream: TcpStream) -> Connection { Connection { stream: BufWriter::new(stream), buffer: BytesMut::with_capacity(4096), } } } }

接下来会实现 write_frame():

#![allow(unused)] fn main() { use tokio::io::{self, AsyncWriteExt}; use mini_redis::Frame; async fn write_frame(&mut self, frame: &Frame) -> io::Result<()> { match frame { Frame::Simple(val) => { self.stream.write_u8(b'+').await?; self.stream.write_all(val.as_bytes()).await?; self.stream.write_all(b"\r\n").await?; } Frame::Error(val) => { self.stream.write_u8(b'-').await?; self.stream.write_all(val.as_bytes()).await?; self.stream.write_all(b"\r\n").await?; } Frame::Integer(val) => { self.stream.write_u8(b':').await?; self.write_decimal(*val).await?; } Frame::Null => { self.stream.write_all(b"$-1\r\n").await?; } Frame::Bulk(val) => { let len = val.len(); self.stream.write_u8(b'$').await?; self.write_decimal(len as u64).await?; self.stream.write_all(val).await?; self.stream.write_all(b"\r\n").await?; } Frame::Array(_val) => unimplemented!(), } self.stream.flush().await; Ok(()) } }

下面这些被用到的函数都由 AsyncWriteExt trait 提供。他们在 TcpStream 上也是可用的,但不建议在没有中间缓冲区的情况下发出单字节写入(一次就发一个字节,会导致太多的 syscall,太浪费资源了)。

write_u8把单个字节写入 writer。write_all把整个切片写入 writer。write_decimal是 mini-redis 实现的,用于把一个十进制数字转化成字符后写入。

函数以一个 self.stream.flush().await 调用结尾。因为 BufWriter 会把要写入的东西先存到一个中间缓冲区,调用 write 不能保证数据被写入 socket,而在返回之前我们想要 frame 被写入 socket。调用 flush() 会将挂在缓冲区上的所有数据写入 socket 。

另一种选择是不在 write_frame() 中调用 flush() 。相反,在 Connection 上提供一个 flush() 函数。这将允许调用者将多个小 frame 写入到缓冲区中的队列,然后使用一个 write syscall 将它们全部写入 socket。但是这会增加 Connection API 的复杂度,而简单是 Mini-Redis 的其中一个目标,所以我们决定让 flush().await 调用包含在 fn write_frame() 中。

Async in depth (深入异步)

至此,我们已经完成了一个相当全面的异步 Rust 和 Tokio 之旅。现在我们将会深挖 Rust 的异步运行时模型。在本教程的开始,我们就提到了 异步 Rust 用了一种独一无二的方法。现在我们来解释一下是啥意思。

Futures

作为快速回顾,我们来举一个非常基本的异步函数。与教程到目前为止所涵盖的内容相比,这并不是什么新鲜事。

#![allow(unused)] fn main() { use tokio::net::TcpStream; async fn my_async_fn() { println!("hello from async"); let _socket = TcpStream::connect("127.0.0.1:3000").await.unwrap(); println!("async TCP operation complete"); } }

我们调用了这个函数,并且返回了某个值,对这个值调用 .await。

#[tokio::main] async fn main() { let what_is_this = my_async_fn(); // Nothing has been printed yet. what_is_this.await; // Text has been printed and socket has been // established and closed. }

my_async_fn() 返回的值是一个 future ,future 是一个实现了标准库提供的 std::future::Future trait 的值。它们是包含正在进行的异步计算的值。

std::future::Future trait 的定义如下:

#![allow(unused)] fn main() { use std::pin::Pin; use std::task::{Context, Poll}; pub trait Future { type Output; fn poll(self: Pin<&mut Self>, cx: &mut Context) -> Poll<Self::Output>; } }

关联类型( associated type ) Output 是 future 一旦完成后会产生的类型。可以通过看标准库文档(standard library)得到更多细节。

不像其它语言实现的 future ,一个 Rust 的 future 不是代表一个正在后台发生的计算,而是 Rust future 就是计算本身。future 的所有者负责通过 poll the future 来推动计算,这就是 Future::poll 所做的事。

Implementing Future (实现 Future)

让我们实现一个简单的 future。这个 future 将会:

-

一直 wait 到特定时刻。

-

输出一些文本到 STDOUT 。

-

产生一个字符串。

use std::future::Future; use std::pin::Pin; use std::task::{Context, Poll}; use std::time::{Duration, Instant}; struct Delay { when: Instant, } impl Future for Delay { type Output = &'static str; fn poll(self: Pin<&mut Self>, cx: &mut Context<'_>) -> Poll<&'static str> { if Instant::now() >= self.when { println!("Hello world"); Poll::Ready("done") } else { // Ignore this line for now. cx.waker().wake_by_ref(); Poll::Pending } } } #[tokio::main] async fn main() { let when = Instant::now() + Duration::from_millis(10); let future = Delay { when }; let out = future.await; assert_eq!(out, "done"); }

Async fn as a Future (异步函数作为 future)